China’s AI offensief en de opmars van LLM’s

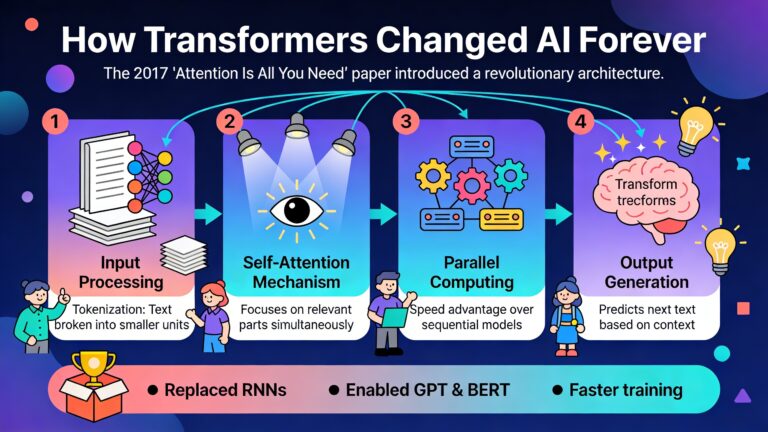

De strijd om AI-wereldmacht wordt vandaag uitgevochten op het niveau van large language models (LLM’s) – hyperintelligente taalmodellen die niet alleen tekst genereren maar inmiddels code schrijven, afbeeldingen begrijpen en complexe analyses uitvoeren. De tijd dat enkel Amerikaanse spelers als OpenAI, Google en Anthropic de plak zwaaiden is voorbij: Chinese techgiganten en academische knooppunten trekken stevig aan de kar. We duiken dieper in hoofdrolspelers van de Chinese LLM’s, hun inzetbare sterktes, waar ze echt innovatief zijn, en waarom zelfs hun best presterende modellen (nog) niet wereldwijd het meest gebruikt worden.

We focussen op de drie absolute smaakmakers: DeepSeek, Qwen (Tongyi Qianwen) en ERNIE, en koppelen deze aan inzichten uit China’s academische hubs.

China’s paradepaardjes

DeepSeek: prijsbreker en pionier in efficiënte, redenerende AI

DeepSeek is in de AI-community de afgelopen jaren razendsnel opgeklommen van outsider tot referentie. Het vlaggenschip DeepSeek-V3 is een echte mastodont van 671 miljard parameters, maar door de Mixture-of-Experts (MoE) architectuur worden er per taak slechts 37 miljard parameters geactiveerd. Resultaat? Een model dat niet alleen slim, maar ook opmerkelijk efficiënt is. Voor beeldvorming: DeepSeek-V3 trainde aan een fractie van het budget van GPT-4 (ongeveer $5,6 miljoen tegenover $50-100 miljoen voor GPT-4).

Redeneren, wiskunde en code voor een prikje

Waar DeepSeek écht in uitblinkt, is in redeneertaken (reasoning), wiskundige problemen en het schrijven van broncode. DeepSeek-R1, de opvolger van V3, gaat nog een stap verder met een expliciete “chain-of-thought” bij elk antwoord. Je ziet de redeneringsstappen transparant verschijnen vooraleer het eindantwoord komt. In diverse benchmarks (AIME, MATH-500, LiveCodeBench) presteert R1 niet alleen beter dan veel Westerse concurrenten, maar blijft prijskaartje en compute honger opmerkelijk laag. Dankzij Generative Reward Modeling (GenRM) en Self-Principled Critique Tuning (SPCT) sleepte DeepSeek efficiëntie- en kwaliteitsprijzen binnen.

- Innovaties: (Mixture-of-Experts) MoE-architectuur, zelflerend via reinforcement learning, chain-of-thought explicitering.

- Toepassingen: Het oplossen van complexe wiskundige raadsels, analyses met lange context (tot 128.000 tokens), interpreteren van beeldmateriaal, genereren van code, en alles daartussen.

- Kostenefficiënt: Dankzij selectief activeren van experts bespaart DeepSeek tot 70% op rekenkracht t.o.v. dense modellen.

Open source, distillatie en adoptieproblemen

DeepSeek zet fors in op opensource en biedt naast de gigantische topmodellen ook “gedistilleerde” (lees: efficiënter, kleiner) LLM’s (van 1,5B tot 70B parameters), die verrassend dicht in de buurt komen van de reasoning capaciteiten van de groten. Toch blijft internationale adoptie vaak haperen, niet door prestatie, maar vanwege geopolitieke argwaan, licentie-onduidelijkheid en angst voor “verborgen invloeden” (zowel reëel als imaginaire).

Alibaba’s Qwen (Tongyi Qianwen): schaalbaarheid en veelzijdigheid in één

Alibaba’s Tongyi Qianwen, internationaal vaak bekend als “Qwen”, staat bekend om zijn mix van brute kracht en flexibiliteit. Qwen2.5 en diens “Max” versie behoren tot de meest geavanceerde multimodale Chinese LLM’s. Met contextwindows tot 1 miljoen tokens en ondersteuning voor zowel tekst- als visuele input speelt Qwen een rol in sectoren van e-commerce en klantenservice tot softwareontwikkeling.

- Architectuur: Geavanceerde variant van Mixture-of-Experts, met focus op energiezuinigheid en reduced latency.

- Benchmarks: Qwen2.5-Max scoort op MMLU en andere taaltests op hetzelfde niveau als GPT-4o en DeepSeek V3.

- Multimodaal: Qwen-VL, de visuele uitloper, verwerkt tekst én beeld in complexe taken zoals OCR, data-visualisatie en beeld-gebaseerd redeneren.

- Kost: Met $0,38 per miljoen tokens één van de goedkoopste LLM’s voor grootschalig gebruik, door verstandig omgaan met compute.

- Talen: Ondersteunt 29+ talen, waaronder alle grote Europese talen, Russisch, Japans, Koreaans, Vietnamees, Arabisch, enz.

Het open karakter (deels open source beschikbaar via Model Studio) en verschillende gradaties in grootte (van 7B tot 72B parameters) maken Qwen breed inzetbaar. Toch blijft grootschalige internationale enterprise-adoptie voorlopig beperkt, mede door compliance-zorgen en gebrek aan transparantie over trainingsdata.

Baidu’s ERNIE: de kennisverrijker met focus op semantiek

ERNIE, het AI-hoofdstuk van Baidu, viel al op door zijn “knowledge-enhanced” aanpak. ERNIE is niet zomaar een tekstpapegaai, maar koppelt kennisgrafen aan grote taalmodellen waardoor relaties en context veel dieper worden begrepen.

- Framework: Koppelt gestructureerde kennis aan tekst, cruciaal voor sectoren met veel jargon (gezondheidszorg, finance, wetenschap).

- Performance: Vooral op Chinese taalbenchmarks en kennisintensieve taken blijft ERNIE scoren. In het domein van CVD (cardiovasculaire ziekten) antwoorden bijvoorbeeld overtreft ERNIE zijn concurrenten in zelfverbeterend vermogen en herkent het beter waar het eigen antwoord mogelijk fout zit.

- Adoptie: Staat qua marktaandeel stevig aan de top van alle Chinese AI-chatbots. Is wijdverspreid in bedrijfsleven en overheid.

- Innovatie: Door de semantische uitbouw werkt ERNIE goed voor inhoudelijke analyse, informatieretrieval, coden en meer.

Toch blijkt ERNIE’s sterke nationale focus een beperking. De optimale prestaties situeert het model steevast in ‘t Chinees. In internationale medische evaluaties (zoals preventie van cardiovasculaire ziekten) scoorden Engelstalige chatbots (zoals GPT-4) hoger op accuracy en consistentie dan ERNIE in het Chinees.

Overzicht: andere commerciële en academische Chinese LLM’s

- ByteDance – Doubao: Ultramodern MoE-model dat uitblinkt in lange-contexttaken (tot 256.000 tokens) en documentanalyse. Doubao is vijf keer goedkoper dan DeepSeek om te draaien.

- Moonshot AI – Kimi: Multimodale specialist, vooral krachtig in complexe, langlopende taken en visuele analyse (bv. medische beeldvorming, financiële grafieken), plus krachtige policy optimization features.

- Zhipu AI – GLM-4 (ontwikkeld aan Tsinghua University): De kracht van GLM-4 ligt in dialoog en code met extra PPO-optimalisatie, en een contextwindow tot één miljoen tokens voor reuzegrote documenten.

- Beijing Academy of AI – WuDao: Open-source, kleinere, zeer efficiënte chat- en codeermodellen (AquilaChat, AquilaCode). Ideaal voor Chinese startups die snel een eigen AI-laag willen bouwen.U

Universiteiten zoals BAAI, Tsinghua en Peking University spelen een voortrekkersrol

Chinese universiteiten en onderzoeksinstituten hebben de voorbije jaren bijna industrieel AI-talent afgeleverd dat directe concurrentie levert met commerciële giganten.

- Beijing Academy of Artificial Intelligence (BAAI): Maakte CPM en WuDao Aquila modellen, met focus op modulaire architectuur en domeinspecialisatie (bv. code, dialoog, beeldtaal).

- Tsinghua: Stuwt innovatie met GLM (General Language Model), een hybride van GPT-achtige en BERT-achtige netwerken, wat zowel generatieve als begrijptaken in één architectuur mogelijk maakt.

- Peking University: Uitvinder van de ERNIE-familie en BELLE, beide pioniers op het vlak van kennisgeïntegreerde modellen en aanpasbaarheid voor sector-specifieke taken.

- Andere toppers: SJTU (MOSS-conversatiemodel), CAS (BriVL, multimodaal), Zhejiang U (efficiënte LLM’s voor onderzoek).

Opmerkelijk is hoe universitaire samenwerkingen met de industrie (vooral via spin-offs, zoals Zhipu AI en 01.AI) de scheiding tussen onderzoek en toepassing vervagen: veel van China’s toppers krijgen hun eerste boost aan de universiteit.

Waar Chinese LLM’s écht uitblinken

Talen en context

Chinese LLM’s zijn ongeëvenaard op vlak van Chinese taalverwerking en contextgevoelige redenering in complexe situaties zoals overheid, finance of farmacie. De meertalige kracht van Qwen (meer dan 29 talen), DeepSeek (vooral Chinees en Engels) en Kimi (uitstekend in lange documenten, 128K-tokens) gooit hoge ogen. Vertalen voor een internationale context blijft voor veel modellen echter nog wat achter op toppers van OpenAI, Google en Meta.

Redeneren, wiskunde en code

De allergrootste sterkte is echter de sprong in chain-of-thought reasoning en codegeneratie. DeepSeek’s R1, samen met Qwen2.5-Max en Kimi, scoren op reeksen zoals AIME, MATH-500 en LiveCodeBench zelfs beter dan GPT-4o of Claude-3.5 Sonnet – en dat tegen een fractie van de prijs.

Bovendien laten de Chinese modellen, via distillatie en verfijnde reinforcement learning, toe om reasoning naar kleinere, betaalbare modellen te brengen. Voor sectoren als onderwijs, research, legal, finance en customer support is dat een gamechanger. Waar Amerika vooral uitblinkt met mammoeten, brengt China reasoning slim naar het midden- en kleinbedrijf.

- DeepSeek-R1: Transparante redenering, eenvoudig toe te passen in complexe pipelines (bv. examenbeoordeling, financiële compliance).

- Qwen2.5: Lange teksten verwerken en samenvatten – tot manuscripts van honderden pagina’s.

- ERNIE: Kennisbewuste verwerking van context en jargon (vooral in medische, farmaceutische en wetenschappelijke context).

Kost en efficiëntie

Het grootste wapenfeit van Chinese teams? Efficiëntie. Waar Amerika massaal inzet op ruwe rekenkracht, wringt China met minder hardware alles uit zijn clusters. DeepSeek trainde V3 bijvoorbeeld met “slechts” 2.000 Nvidia H800’s, en ontwikkelde technieken om reasoningmodellen tot 70% goedkoper te maken. Verschillende modellen draaien dankzij slimme MoE-architectuur én goedkope chips op een fractie van de Amerikaanse kost, ideaal voor brede uitrol in grote organisaties.

Uitdagingen op weg naar wereldheerschappij

Technische knelpunten: compute en chips

Ondanks alles blijft de echte crux de beschikbaarheid van geavanceerde chips en rekenkracht. Amerikaanse exportcontroles (en slabakkende eigen productie van cutting-edge hardware) zorgen ervoor dat zelfs de meest innovatieve Chinese labs moeten improviseren, stokoude A100’s recycleren of enorme clusters bouwen van minder efficiënte chips. Dit zorgt voor hogere kosten, langere trainingstijden én een achterstand bij sprongen naar next-gen AI’s die honderdduizenden GPU’s vereisen.

- Amerika beschikt over minstens tien keer meer AI compute dan China, vooral door voorsprong in high-end Nvidia-chips (B200, H100) en de hele software- en netwerkinfrastructuur errond.

- Gevolg: China kan starstraining én uitrol wel doen op beperkte schaal, maar mist schaalbaarheid richting wereldmarkt.

- Zelfs chipproductiesluipwegen zoals smokkel uit Maleisië kunnen deze kloof slechts tijdelijk dichten.

- De Huawei Ascend 910C is een AI-chip, ontwikkeld door Huawei, biedt een alternatief voor de chips van Nvidia. Door het afsluiten van de toevoer van hoogperformante chips heeft China moeten inzetten op zelfredzaamheid. Iets waar Europa van kan leren.

Data, kwaliteit en culturele finesse

Chinese LLM’s zijn getraind op immense hoeveelheden data, maar deze zijn vaak hoofdzakelijk Chinees en weinig divers qua cultuur, context, sfeer en wetgeving. Bij content in het Nederlands, Frans of Duits is de output in vergelijking met echt wereldwijde modellen (zoals GPT-4o) minder accuraat, idiomatisch en gevoelig voor culturele nuances.

- Voor toepassingen in Europa of Noord-Amerika merken bedrijven dat Belgische, Nederlandse of Franse gevoeligheden of contexten soms compleet genegeerd worden.

Censuur, vertrouwen en geopolitieke schroom

Zelfs de beste open modellen (DeepSeek, Qwen) worden in Europa en Amerika minder gebruikt door geopolitieke en compliance-angsten. Bedrijven vrezen verborgen censuur (vooral op gevoelige politieke thema’s), indirecte beïnvloeding of compliance-zorgen. Zelf al zijn deze zorgen technisch gezien vaak overroepen. Dit remt commerciële adoptie in sectoren zoals finance, overheid en healthcare.

- Open modellen uit China worden zelden voor mission-critical toepassingen gekozen uit vrees voor politieke backdoors of compliance-issues. Ook al is er zelden bewijs van reële risico’s.

- Westerse bedrijven proberen soms DeepSeek of Qwen te “de-censureren”, maar botsen dan weer tegen derden-moderatie als ze met Microsoft/Azure werken.

Desondanks blijkt uit studies dat Chinese modellen op sommige gevoelige topics zelfs permissiever zijn dan Amerikaanse tegenhangers, vooral wanneer deze aan extra moderatie onderhevig zijn door hosting op Amerikaanse clouds.

Regels en ecosystemen: van lokale constructie naar wereldexport

Hoewel de Chinese overheid stimulansen en ondersteuning biedt, legt ze tegelijk tal van lokale beperkingen op (denk aan security-audits, contentmonitoring en dataprivacy volgens PIPL (de Chinese GDPR). Voor exportmodellen zorgt het verschil in richtlijnen voor extra compliancehoofdpijn. Ook de afwezigheid van sterke internationale branding werkt niet mee: Amerikaanse merken als OpenAI, Google en Anthropic halen wereldwijd meer pers en vertrouwen door hun bekendheid.

Het risico bestaat dat China’s focus op “AI for China”-oplossingen de ontwikkeling van makkelijk “exporteerbare”, cultureel flexibele modellen tegenhoudt – een grote handicap in de jacht op de wereldtop.

Hoe ziet de (nabije) toekomst eruit?

De wedloop tussen Chinese en Amerikaanse LLM-titanen is voorlopig allesbehalve gestreden. Met een reusachtige thuismarkt als lanceerplatform, focus op efficiëntie en overvloeding aanwezig academisch talent bouwt China gestaag verder aan meer robuuste, gespecialiseerde modellen. Verwacht wordt dat de komende jaren:

- Efficiëntie-innovaties zoals bij DeepSeek zullen doorzetten, zodat China de hardwarekloof deels kan compenseren.

- Specialisatie voor verticale sectoren en lokale markten voorop komt te staan, eerder dan de jacht op één wereldwijd GPT-alternatief.

- De landen in Chinese invloedssfeer (Zuid-Oost Azië, Afrika, sommige Arabische en Brics landen) alsnog sneller Chinese modellen zullen kiezen door bestaande economische banden/vertrouwen.

- Er extra wordt ingezet op eigen chipontwikkeling en software-ecosystemen. Zelfvoorziening is de heilige graal.

- Diplomatieke inspanningen toenemen om AI-regels te harmoniseren én vertrouwen te winnen bij buitenlandse partners.

Kortom: expect minder “one size fits all” en veel meer AI die dicht op lokale markt/sector inzet.

De motor blijft draaien, maar de uitdaging is niet enkel technologisch – het is evenzeer geopolitiek, cultureel en menselijk.

Van rekenkracht tot cultuurstrijd – China’s LLM’s staan op een scharnierpunt

Wie dacht dat AI-innovatie nog enkel in Silicon Valley gemaakt wordt, moet dringend bijbenen. De technologische voorsprong van Amerika is niet onoverbrugbaar, en China bewijst dat creativiteit en efficiëntie even sterk kunnen wegen als overvloedig schaalbare “compute”. DeepSeek, Qwen en ERNIE tonen het technologisch vernuft. Vlaamse bedrijven en instellingen die willen meespelen met cutting-edge AI doen er goed aan niet klakkeloos in USA-centrisme te blijven hangen.

De barrières naar wereldwijde dominantie voor Chinese LLM’s zijn niet min: hardware, regelgeving, culturele aanpassing, marktvertrouwen. Wie die kliffen weet te overbruggen, maakt echt kans om de bakens te verzetten. De toekomst is meertalig, multicultureel en open. Misschien binnenkort dankzij een AI uit Beijing, Hangzhou of Shanghai.