Inleiding: de opmars van Deepseek R1 in het AI-landschap

Deepseek R1, het Chinese opensource redeneermodel, zette de AI sector begin 2025 volledig op zijn kop. Onderzoekers, ontwikkelaars en technologiebedrijven wereldwijd kijken vol verbazing naar wat tot voor kort nog als een ‘Amerikaanse speeltuin’ werd beschouwd. Deepseek R1 heeft in een mum van tijd niet alleen zijn plek opgeëist naast giganten als OpenAI en Google, maar miste tegelijkertijd zijn entree in de mainstream niet: het model klom veel sneller dan verwacht naar de bovenste regionen van de App Store, liet gevestigde namen als ChatGPT achter zich, en zorgde zelfs even voor onrust op de beurs. Maar wat is Deepseek R1 nu eigenlijk? Wat maakt de nieuwste release R1-0528 zo bijzonder?

Wie of wat is Deepseek?

Deepseek is een Chinese AI-onderneming uit Hangzhou, opgericht in mei 2023 onder de vleugels van High-Flyer, een succesvol quant hedge fund in China. Oprichter Liang Wenfeng, een alumni van Zhejiang-universiteit, had zijn strepen al verdient als medeoprichter van High-Flyer. Deepseek concentreert zich geheel op het bouwen van opensource large language models (LLM’s) die technologisch concurreren met de top van het Westen, maar tegen een fractie van de kost. Transparantie en open source vormen de basisprincipes. De eerste modellen doken eind 2023 op, maar pas met de lancering van Deepseek R1 in januari 2025 kwam het bedrijf op de internationale radar terecht.

Deepseek R1: waar draait het om?

Deepseek R1 is het vlaggenschip onder de Deepseek-modellen en mikt specifiek op het verbeteren van redeneervermogen bij LLM’s. Dat betekent sterkere prestaties op domeinen als wiskunde en codegeneratie. Deepseek R1 gebruikt ‘chain-of-thought reasoning’. Dit is het vermogen om stap voor stap logische redeneringen op te bouwen.

Het model onderscheidt zich in het bijzonder doordat het volledig opensource is (MIT-licentie), significant goedkoper werd getraind dan concurrenten (minder dan $6 miljoen voor het hele traject), en wereldwijd vrij gebruikt en aangepast mag worden.

De eerste Deepseek R1-release veroorzaakte een echte hype. In de eerste dagen schoten de downloads en gebruikersaantallen van de bijhorende chatbot-app de hoogte in, met als resultaat dat Deepseek R1 zelfs even meer tractie kreeg dan OpenAI’s ChatGPT. Het had bovendien een bijzonder effect op de waarde van Amerikaanse techspelers: hun aandelen doken naar beneden uit vrees voor een ‘Chinese AI-tsunami’. Nvidia, Microsoft en Meta zagen in een klap vele miljarden aan marktwaarde verdampen.

Hoe is Deepseek R1 technisch opgebouwd?

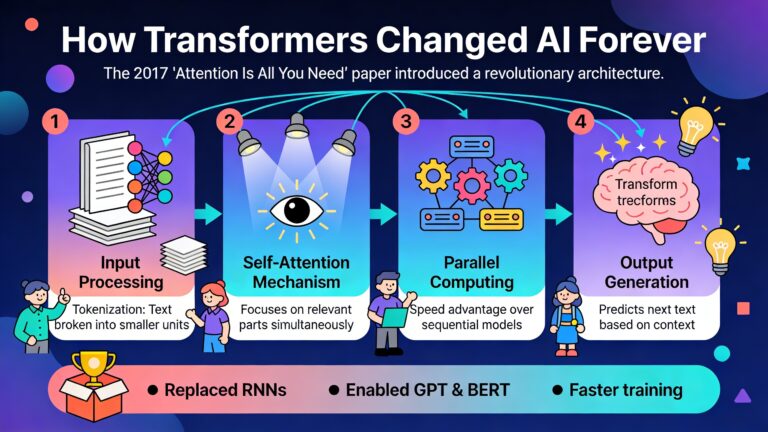

Deepseek R1 is een ‘reasoning LLM’ dat gebruik maakt van reinforcement learning (RL). De meeste modellen gebruiken supervised fine-tuning (SFT). Mensen geven aan welk resultaat verwacht wordt.

Deepseek R1 paste grootschalig reinforcement learning toe op hun basismodel (Deepseek V3-Base). Deze aanpak laat het model zelf efficiënter leren om stap voor stap complexe problemen op te lossen. Het model kreeg dus ‘beloningen’ wanneer het een goede redeneringsstap zette, zonder eerst expliciet miljoenen voorbeelden te moeten krijgen van menselijke trainers.

In de praktijk ontstond Deepseek R1 binnen twee hoofdtrajecten:

- Deepseek R1-Zero: direct met RL getraind, zonder SFT. Dit model liet opvallende redeneringsvaardigheden zien, maar ook problemen zoals herhalingen, minder leesbaarheid of slordige taal.

- Deepseek R1: een verbeterde, productiegerichte versie die wél een initiële SFT-fase kreeg vóór de RL-stap. Hierdoor scoort het model sterker op consistentie, leesbaarheid en stabiliteit – en dat is exact waar OpenAI’s o1-modellen concurrentie krijgen.

Belangrijkste technische highlights

- State-of-the-art redeneercapaciteiten: Deepseek R1 bereikt prestaties vergelijkbaar met of beter dan OpenAI’s o1 op benchmarks voor wiskunde, code, en logische problemen.

- Mixture of Experts architectuur (MoE): het model bevat meerder modellen, experts genaamd. Ieder model is gespecialiseerd in één domein. Afhankelijk van de prompt wordt er gecommuniceerd met de meest geschikte expert.

- Groot en krachtig: het model telt, afhankelijk van de versie, tot 685 miljard parameters. Dat maakt het tot een van de grootste opensource LLM’s tot nu toe. Tijdens het bevragen van het model gebruik je maximaal 37 miljard parameters. Hierdoor krijg je de voordelen van een groot model zonder de overhead voor het rekenwerk als je alle parameters zou gebruiken.

- Uitgebreide output: Deepseek R1-0528 kan tot 164.000 tokens genereren in één output, ideaal voor langere code, complexe analyses, of uitgebreide redeneringen. De vorige versie kon maximum 32.000 tokens genereren.

- Open source: je mag het model gebruiken, aanpassen, distilleren en integreren in commerciële toepassingen zonder restricties (MIT-open source license).

- Kleinere modellen: naast het hoofdmodel zijn er zes kleinere, ‘gedistilleerde’ modellen, gebaseerd op Qwen en Llama, die ook opensource zijn – waardoor het model ook op minder krachtige hardware kan draaien.

- Technisch: ondersteuning voor Json en function calling zitten standaard ingebakken in het model.

Wat is er nieuw in de laatste Deepseek release R1-0528?

De nieuwste release van Deepseek R1 betekent geen revolutionaire sprong, maar wel een reeks opvallende verbeteringen en uitbreidingen, vooral gericht op bruikbaarheid, beschikbaarheid en technische stabiliteit:

- Update via Hugging Face: in plaats van een stevige marketing campagne te voeren heeft Deepseek zijn nieuwste model gewoon op Hugging Face geplaatst zodat iedereen het kan downloaden en proberen.

- Optimalisaties van de reinforced learning: Interne tweaks aan het leerproces zorgen voor een hogere betrouwbaarheid, minder herhaling, betere alignering met de menselijke instructies. Het chain-of-thoughts proces is verbeterd. Het reinforced learning proces is nu meer gefinetuned zodat het model met minder data sneller tot betere resultaten komt.

Wat onderscheidt Deepseek R1 van OpenAI en andere concurrenten?

Sinds de lancering van ChatGPT en de GPT-4-architectuur geldt OpenAI als de onbetwiste leider in westerse AI-ontwikkeling. Toch hanteert Deepseek een radicaal andere koers:

- Openheid als wapen: Waar OpenAI’s modellen grotendeels achter gesloten deuren blijven qua code en gewichten, gooit Deepseek alles open. Gebruikers kunnen modellen downloaden, aanpassen, fine-tunen, distilleren, én zonder restricties inzetten.

- Kostenefficiënt trainen en gebruik: Deepseek R1 werd met amper enkele miljoenen dollars getraind dankzij efficiënt gebruik van reinforced learning en beperkte infrastructuur. Ter vergelijking: GPT-4 zou naar schatting honderden miljoenen dollars aan training kosten. Deepseek R1 is veel goedkoper om te gebruiken dan de redeneermodellen van an

- Lichte modellen, zware prestaties: De distillatie-aanpak maakt krachtige reasoningmogelijkheid ook bruikbaar voor kleinere servers of edge devices – niet enkel de reuzen in de cloud.

- Chinese context en data: Deepseek R1 is getraind met een wereldbeeld dat deels Chinees is, iets waar vooral in het Westen vragen bij gesteld worden. Toch draagt dit ook bij aan unieke performantie op taken en talen die in Europese/Amerikaanse modellen vaak minder goed aan bod komen.

Controverse rond Deepseek R1

Bans, data en geopolitiek

Het succes van Deepseek roept in het Westen argwaan op. Verschillende organisaties hebben Deepseek al verboden, onder andere omwille van zorgen rond privacy en mogelijke blootstelling van data richting Chinese overheid. Omdat alle gebruikersdata initieel in China wordt opgeslagen, vrezen beleidsmakers voor potentiële lekken of misbruik. Een absurd argument want je kan Deepseek op je eigen servers draaien.

Er zijn ook incidenten geweest waarbij gevoelige backend-data, API-keys en chatlogs door menselijke fouten tijdelijk publiek raadpleegbaar waren. Deepseek pakte dergelijke problemen telkens meteen aan.

Cybersecurity en aanvallen

Rond het hoogtepunt van Deepseek R1’s populariteit, eind januari 2025, werd het platform bovendien het doelwit van een grootschalige cyberaanval. Het concern moest tijdelijk zelfs nieuwe gebruikersstoppen doorvoeren om de infrastructuur te beschermen. Uiteindelijk bleef de dienstverlening voor bestaande klanten overeind dankzij snelle tussenkomst, maar het was meteen duidelijk: hoe meer impact een AI-model, hoe aantrekkelijker het doelwit.

Waar kan je Deepseek R1 uitproberen of integreren?

Deepseek R1 kan je op verschillende manieren direct gebruiken:

- Op chat.deepseek.com kab je het model gebruiken. Kies voor ‘DeepThink’ modus.

- Via het Deepseek Platform kan je terecht voor een OpenAI-compatibele API. Die laat integratie in bestaande pipelines toe zonder dat je zelf infrastructuur moet onderhouden.

- Dankzij Hugging Face zijn het model en de gewichten voor experimenten, fine-tuning en onderzoek makkelijk te downloaden en in diverse frameworks in te laden.

- Voor cloudintegratie zijn de modellen nu ook beschikbaar op AWS (via Bedrock en SageMaker) – ideaal voor schaalbare AI-projecten met maximale performantie.

Benchmarks en prestaties

Deepseek R1 en zijn varianten bieden veelzijdige prestaties:

- De officiële benchmarks tonen vergelijkbare resultaten met OpenAI’s o1 op het vlak van logica, rekenkracht, en softwareontwikkeling.

- Distilled models(32B en 70B): beter dan OpenAI-o1-mini voor dense reasoning.

De prestaties van Deepseek R1 zijn state-of-the-art in de sector, vooral als reasoning primeert over pure kennisreplicatie. De combinatie van snelle inference, hogere betrouwbaarheid, en de mogelijkheid tot volledige fine-tuning op eigen data scharen het model pal in de kopgroep van LLM’s.

De toekomst van open reasoning AI

Deepseek kiest radicaal voor open source. Iedereen kan nu de performantste reasoning-LLM’s van het moment niet enkel gebruiken, maar ook aanpassen. Je bent niet meer afhankelijk van gesloten Amerikaanse spelers. Voor ontwikkelaars in Vlaanderen en Europa betekent het hoop. Eindelijk kan je mee aan het stuur van cutting edge reasoning-AI staan, met volledige controle over privacy, infrastructuur en kosten.

De AI-wereld neigt naar meer openheid, democratisering en diversificatie van brondata en use cases. Deepseek R1 is het boegbeeld van deze trend, met een Chinese twist. Wie had ooit gedacht dat een Chinese opensource LLM, getraind voor een peulschil, zoveel schokgolven door het wereldwijde technologische ecosysteem zou jagen? De toekomst is open.