Wanneer trial-and-error niet genoeg is

Stel je voor dat je een nieuw bordspel leert zonder dat iemand je de regels uitlegt. Je speelt een potje, verliest, en probeert het opnieuw. Na tientallen pogingen begin je patronen te herkennen. Maar wat als je na elke verliesbeurt even de tijd nam om te bedenken waarom je verloor en hoe je het anders zou aanpakken? Je zou waarschijnlijk veel sneller verbeteren.

Precies dit principe ligt aan de basis van Experiential Reinforcement Learning, kortweg ERL. Het is een trainingsparadigma voor taalmodellen dat verder gaat dan het klassieke trial-and-error van standaard reinforcement learning. In plaats van puur te leren van een beloningssignaal aan het einde van een poging, bouwt ERL een expliciete reflectiestap in het leerproces zelf. Het resultaat is een model dat sneller leert, stabieler traint en uiteindelijk beter presteert, zonder dat die verbeteringen extra kosten bij het gebruik van het model.

Wat is Experiential Reinforcement Learning?

Reinforcement learning is een leermethode waarbij een model acties uitvoert in een omgeving en op basis van beloningen leert welk gedrag gewenst is. In de praktijk zijn die beloningen vaak schaars en vertraagd. Een model krijgt pas aan het einde van een reeks beslissingen te horen of het goed of slecht deed. Dat maakt leren moeilijk: het model moet zelf uitzoeken welke stap in een lange keten verantwoordelijk was voor succes of falen.

Standaard reinforcement learning met verifieerbare beloningen, ook wel RLVR genoemd, lost dit op door het model herhaaldelijk te laten proberen en de beleidsparameters bij te sturen op basis van de ontvangen beloning. Maar de correctieve structuur, het inzicht in waarom iets misging en hoe het beter kan, moet het model volledig zelf ontdekken via ongericht verkennen. Dat is traag en inefficiënt.

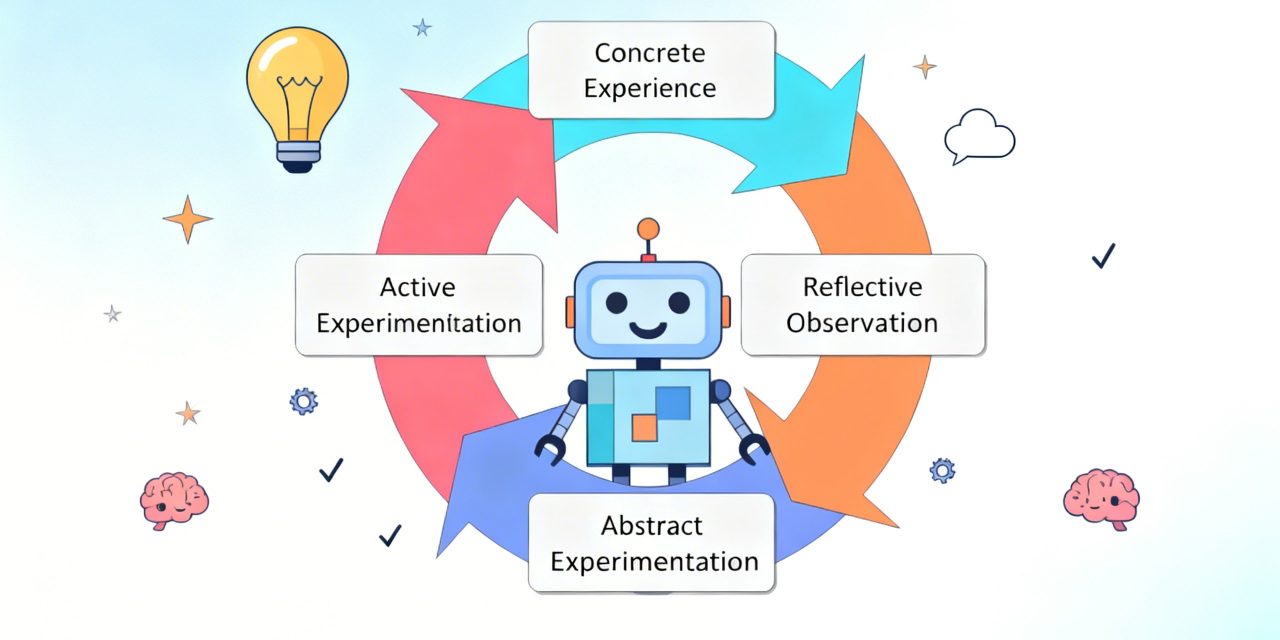

ERL introduceert een fundamenteel andere aanpak. Het paradigma is geïnspireerd op hoe mensen leren: door ervaring op te doen, daarover na te denken, een herzien mentaal model te vormen en dat toe te passen in een volgende poging. Dit cyclische proces, ervaring, reflectie en consolidatie, wordt bij ERL expliciet ingebouwd in het trainingsproces van het taalmodel.

Hoe werkt ERL?

De kern van ERL is een driedelige lus die bij elke trainingsepisode wordt doorlopen.

Eerste poging en feedback

Het model krijgt een taak en genereert een eerste antwoord of reeks acties. De omgeving evalueert dit en geeft feedback terug, samen met een beloningsscore. Als die score hoog genoeg is, is er niets aan de hand en wordt de poging gewoon versterkt via het standaard reinforcement learning-mechanisme. Maar als de eerste poging tekortschiet, treedt de reflectiefase in werking.

Reflectie als tussensignaal

In plaats van de fout simpelweg te registreren als een negatief signaal, genereert het model een expliciete reflectie. Dit is een gestructureerde zelfanalyse: wat ging er mis in de eerste poging, en hoe kan de aanpak worden verbeterd? Die reflectie fungeert als een intern tussensignaal dat de tweede poging stuurt.

Het model produceert vervolgens een verfijnde tweede poging op basis van die reflectie. De omgeving evalueert ook deze poging en geeft opnieuw feedback. Als de tweede poging beter scoort, wordt die versterkt via reinforcement learning. De reflectie zelf krijgt ook een beloningsscore, namelijk de score van de tweede poging. Zo leert het model niet alleen betere antwoorden te geven, maar ook betere reflecties te genereren.

Geheugen over episodes heen

ERL voegt daar nog een laag aan toe: een cross-episode geheugen. Reflecties die tot een succesvolle tweede poging hebben geleid, worden opgeslagen. Bij volgende trainingsepisodes kan het model putten uit dit geheugen om eerder ontdekte correctieve patronen opnieuw te gebruiken. Dit stabiliseert het leerproces en zorgt ervoor dat nuttige inzichten niet verloren gaan na één episode.

Het geheugen werkt als een soort gedeeld kennisreservoir. Wanneer het model een nieuwe taak aanpakt en een reflectie moet genereren, kan het terugvallen op wat eerder werkte in vergelijkbare situaties. Dit versnelt de convergentie en vermindert de afhankelijkheid van puur toeval bij het verkennen van de oplossingsruimte.

Internalisatie zonder reflectie bij gebruik

Een cruciaal onderdeel van ERL is de internaliseringstap. In een echte toepassing is er geen omgevingsfeedback beschikbaar en kan het model niet eerst een poging doen, reflecteren en dan pas antwoorden. Het model moet direct presteren.

ERL lost dit op via selectieve distillatie. Wanneer een tweede poging succesvol is, wordt het model getraind om datzelfde verbeterde gedrag te reproduceren vanuit de originele taakinput, zonder de reflectie als context. De reflectie is als het ware een steiger die tijdens de bouw wordt gebruikt maar daarna wordt weggehaald. Het resultaat, het verbeterde gedrag, blijft ingebakken in het model zelf.

Dit betekent dat alle lessen die tijdens training zijn geleerd via reflectie en feedback, persistent worden in de basisparameters van het model. Bij gebruik hoeft het model niet meer te reflecteren om toch te profiteren van wat het tijdens training heeft geleerd.

Selectieve activatie van de reflectiefase

ERL activeert de reflectiefase niet bij elke poging. Alleen wanneer de eerste poging onder een bepaalde drempelwaarde scoort, wordt de reflectie- en herprobeersequentie gestart. Dit is een bewuste ontwerpkeuze. Als het model al goed presteert op een taak, is reflectie niet nodig en kan het zelfs contraproductief zijn: het model zou dan gaan zoeken naar manieren om de beloning te maximaliseren op manieren die niet generaliseren naar nieuwe situaties. Door reflectie te reserveren voor mislukte pogingen, blijft het leerproces stabiel en gericht.

ERL versus standaard reinforcement learning

Het verschil tussen ERL en standaard RLVR is fundamenteel van aard. Bij RLVR is feedback een scalair eindpuntsignaal. Het model weet dat het goed of slecht deed, maar moet zelf via herhaald verkennen uitzoeken hoe het gedrag moet veranderen. Correctieve structuur ontstaat langzaam en indirect.

Bij ERL wordt feedback omgezet in een tussenliggende redenering. De feedback is niet langer alleen een signaal dat het beleid bijstuurt, maar een katalysator voor onmiddellijke gedragsherziening binnen dezelfde episode. Het model analyseert zijn eigen fout, formuleert een correctie en past die toe, nog voordat de beleidsparameters worden bijgewerkt.

Dit verschil heeft praktische gevolgen. ERL concentreert de trainingupdates op trajecten die al gedeeltelijk in lijn zijn met het doel. Ongericht verkennen wordt vervangen door gerichte herziening. Het model verspilt minder trainingstijd aan pogingen die niets nieuws opleveren.

Een vergelijkbaar idee is te vinden in Meta-Experience Learning, een verwant framework dat fouten analyseert door correcte en incorrecte trajecten te vergelijken en de inzichten daaruit op te slaan in het geheugen van het model. Beide benaderingen delen de kerngedachte dat leren van fouten meer vereist dan het registreren van een negatieve beloning. Het vereist een expliciete analyse van wat er misging en waarom.

De impact van ERL in de praktijk

ERL is getest op een reeks uitdagende taken, waaronder schaarse-beloningsomgevingen en agentische redeneerbenches.

Complexe planningsproblemen

In Sokoban, een puzzelspel waarbij een agent dozen naar doelposities moet duwen, verbeterde ERL de prestaties van het Qwen3-4B-model van 0,06 naar 0,87. Dat is een verbetering van meer dan 1300 procent ten opzichte van standaard RLVR. Sokoban vereist langetermijnplanning en herstel van opeengestapelde fouten, precies het type taak waarbij de reflectielus het meeste oplevert.

In FrozenLake, een navigatiespel op een raster waarbij de agent symbolen en omgevingsdynamiek puur via interactie moet leren, behaalde ERL verbeteringen tot 27 procent. Beide omgevingen geven het model geen expliciete spelregels mee. Het moet alles zelf ontdekken, wat de waarde van gestructureerde reflectie extra benadrukt.

Redeneren met tools

Op HotpotQA, een meerstaps vraag-en-antwoordtaak waarbij het model externe zoektools moet gebruiken om informatie op te halen en samen te voegen, behaalde ERL verbeteringen tot 11 procent. De winst is hier kleiner dan bij de planningsproblemen, wat logisch is: HotpotQA heeft een homogenere interactiestructuur en dichtere beloningssignalen. Standaard RLVR presteert al redelijk goed in dit regime, waardoor de meerwaarde van expliciete reflectie beperkter is.

Leersnelheid en stabiliteit

Naast eindprestaties verbetert ERL ook de leersnelheid. In experimenten bereikte ERL hogere beloningen eerder in het trainingsproces en handhaafde een consistente voorsprong op RLVR gedurende de hele training. Dit is bijzonder relevant in praktische settings waar trainingscompute beperkt is.

De ablatiestudies bevestigen de bijdrage van elk onderdeel. Zonder reflectie daalt zowel de leersnelheid als de eindprestatie aanzienlijk. Zonder geheugen vertraagt de convergentie, maar de eindprestatie blijft grotendeels intact. Volledige ERL, met zowel reflectie als geheugen, levert in de meeste gevallen de beste resultaten.

Wat ERL betekent voor de toekomst van lerende systemen

ERL is meer dan een technische verbetering op een bestaand algoritme. Het vertegenwoordigt een conceptuele verschuiving in hoe we denken over het leren van taalmodellen. Waar supervised fine-tuning modellen traint op vaste voorbeelden en standaard reinforcement learning modellen optimaliseert via beloningssignalen, behandelt ERL ervaring zelf als de primaire bron van verbetering.

De reflectielus maakt van elke mislukte poging een leermoment met structuur. Het geheugen zorgt ervoor dat die leermoment niet verloren gaat. De internaliseringstap garandeert dat de verbeteringen beklijven zonder extra kosten bij gebruik. Samen vormen deze drie elementen een leerproces dat dichter aanleunt bij hoe mensen daadwerkelijk verbeteren: niet door eindeloos te herhalen, maar door bewust te reflecteren en die reflectie te verankeren in toekomstig gedrag.

De interessantste implicatie is misschien wel dat de kwaliteit van de reflectie zelf een bottleneck wordt. Grotere modellen genereren betere reflecties, wat leidt tot betere tweede pogingen, wat leidt tot sterkere internaliseringsignalen. ERL profiteert dus van schaalvergroting op een manier die standaard RLVR niet doet. Naarmate modellen groter worden, wordt de reflectiestap niet alleen nuttiger, maar ook nauwkeuriger.