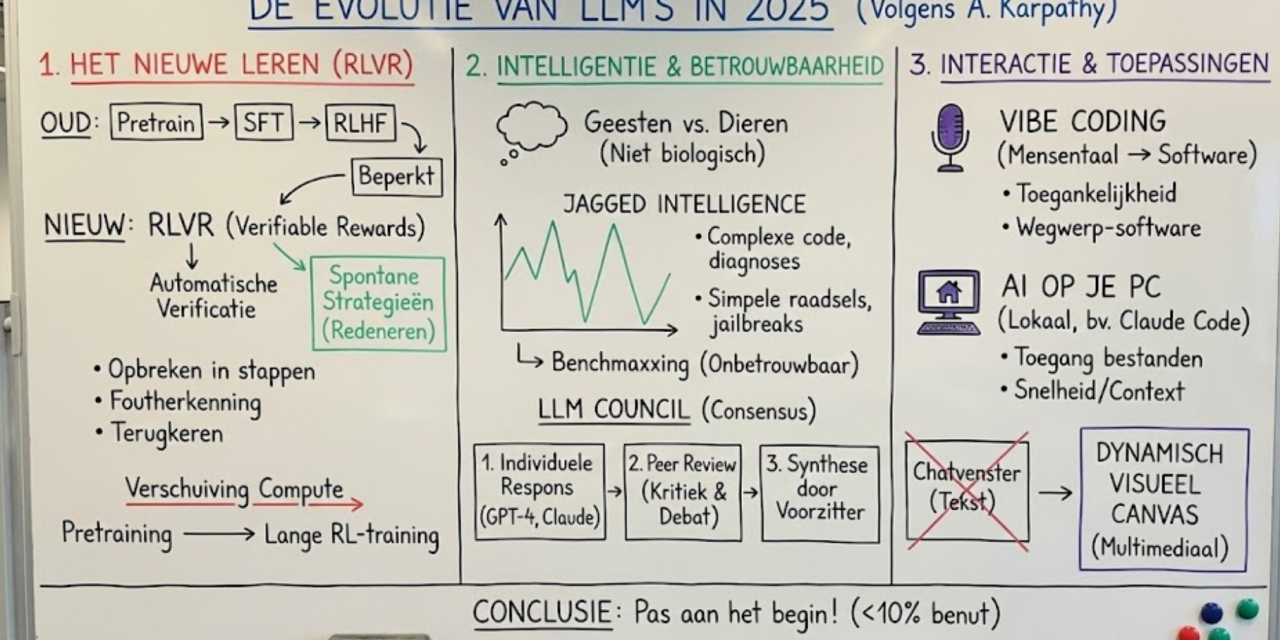

De evolutie van LLM’s in 2025 volgens Andrej Karpathy

Het jaar 2025 zal de geschiedenisboeken ingaan als een scharnierjaar voor artificiële intelligentie. Waar we vroeger vooral keken naar grotere modellen en meer parameters, draaide 2025 om fundamentele paradigmaverschuivingen in hoe Large Language Models (LLM’s) leren, redeneren en met ons interageren. Andrej Karpathy, een van de meest invloedrijke stemmen in de AI-wereld (en voormalig kopstuk bij OpenAI en Tesla), heeft zijn kijk op dit bewogen jaar gedeeld. Zijn inzichten, gecombineerd met nieuwe concepten zoals de LLM Council, schetsen een fascinerend en complex toekomstbeeld.

De doorbraak van RLVR, wanneer AI leert redeneren

Aan het begin van 2025 zag de standaard ‘receptuur’ voor het trainen van een LLM er bij de meeste grote laboratoria vrij gelijkaardig uit: pretraining op enorme datasets, gevolgd door Supervised Fine-Tuning (SFT) en Reinforcement Learning from Human Feedback (RLHF). Dit was de gouden standaard. Maar in de loop van het jaar emergerde er een nieuwe, cruciale stap: Reinforcement Learning from Verifiable Rewards (RLVR).

In plaats van modellen enkel te trainen op het imiteren van menselijke tekst, worden ze nu getraind met automatisch verifieerbare beloningen. Het model krijgt een probleem, probeert het op te lossen, en een geautomatiseerd systeem verifieert of het antwoord klopt.

Het ontstaan van spontane strategieën

Wat Karpathy en andere onderzoekers opmerkten, was opzienbarend. Door deze RLVR-training begonnen modellen spontaan strategieën te ontwikkelen die voor ons mensen lijken op “redeneren”. Ze leerden problemen op te breken in tussenstappen, fouten te herkennen en terug te keren op hun stappen om een nieuwe route te proberen. Dit zagen we duidelijk terug in papers zoals die van DeepSeek R1 en de release van OpenAI’s o3.

Deze strategieën zouden met de oude methodes (SFT en RLHF) nauwelijks kunnen omdat het voor mensen vaak onduidelijk is hoe het optimale denkproces van een AI eruitziet. Het model moet zelf ontdekken wat werkt via optimalisatie via objectieve beloningen. Hierdoor verschoof de rekenkracht (compute) van pretraining naar reinforcement learning, wat zorgde voor modellen die niet noodzakelijk groter waren in omvang, maar wel veel langer getraind werden op specifieke taken.

Geesten versus dieren, Jagged Intelligence

Een van de meest filosofische maar treffende observaties van 2025 is de realisatie dat we AI niet moeten bekijken door een biologische bril. We zijn geen dieren aan het kweken maar geesten aan het oproepen.

De intelligentie van een LLM heeft een totaal andere vorm dan die van een mens. Menselijke neurale netwerken zijn geëvolueerd om te overleven in de jungle, om sociaal te functioneren in een stam. De neurale netwerken van een LLM zijn geoptimaliseerd om menselijke tekst te imiteren en beloningen te scoren in wiskundepuzzels. Het resultaat is wat men Jagged Intelligence (gekartelde intelligentie) noemt.

- De piek: op sommige vlakken is het model geniaal in het schrijven van complexe code het stellen van medische diagnoses.

- Het dal: het zelfde model stuikelt over een simpel raadsel of laat zich misleiden door een eenvoudige jailbreak.

Hierdoor is het vertrouwen in traditionele benchmarks in 2025 flink afgenomen. Benchmarks zijn per definitie verifieerbaar en extreem gevoelig voor RLVR. AI Labs optimaliseren hun modellen specifiek voor deze benchmarks, benchmaxxing. Hierdoor rijzen de scores de pan uit, maar de algemene intelligentie wordt niet beter. Een vreemde paradox, modellen die alle problemen in testen oplossen, maar nog steeds geen AGI (Artificial General Intelligence) zijn.

De opkomst van de LLM Council, betrouwbaarheid door consensus

De jagged intelligence en de neiging van modellen om te hallucineren, zorgt voor een behoefte aan betrouwbaarheid. Eén bron vertrouwen voor kritieke informatie is een risico. Karpathy heeft hier een interessante oplossing voor, de LLM Council.

Meerdere ogen zien meer dan één. De LLM Council is software die fungeert als een interface om meerdere AI-modellen tegelijkertijd te bevragen. Het bootst een vergadering van experts na.

Hoe werkt de LLM Council?

Het proces verloopt in drie duidelijke fases, wat zorgt voor een veel hogere accuraatheid dan een enkele prompt naar ChatGPT of Claude:

- Individuele respons: Je stelt een vraag en verschillende modellen (bijvoorbeeld GPT-4, Claude 3.5 en Llama 3) geven elk hun initiële antwoord, gebaseerd op hun eigen training en biases.

- Peer Review: Dit is de cruciale stap. De modellen krijgen elkaars antwoorden te zien (vaak geanonimiseerd) en leveren kritiek. Ze debatteren als het ware over de juistheid en wijzen op hallucinaties of zwakke argumenten bij de anderen.

- Synthese door de voorzitter: Een Chairman model (vaak het sterkste model) bekijkt alle antwoorden en de kritieken, en synthetiseert dit tot één gebalanceerd, accuraat eindantwoord.

Onderzoek van MIT in 2024 bevestigde al dat modellen betere resultaten leveren wanneer ze elkaar bekritiseren. Voor ontwikkelaars en bedrijven betekent dit een verschuiving. We bouwen geen applicaties meer rond één model of leverancier, maar gebruiken een combinatie van modellen om de zwaktes van het ene model op te vangen met de sterktes van het andere.

Vibe Coding, programmeren voor iedereen

Misschien wel de meest democratiserende trend van 2025 is de doorbraak van “Vibe Coding”. Waar programmeren vroeger het domein was van hoogopgeleide specialisten die de syntax van C++ of Rust tot in de puntjes beheersten, is de drempel nu nagenoeg verdwenen.

Vibe Coding houdt in dat je indrukwekkende software bouwt door simpelweg in mensentaal te beschrijven wat je wilt. Het gaat om de vibe, de intentie, en de functionaliteit.

Dit heeft twee grote gevolgen:

- Toegankelijkheid: Iedereen met een idee kan nu een app bouwen. De macht verschuift naar de creatieveling, niet de technicus.

- Wegwerp-software: Omdat code bijna gratis en snel te genereren is, zien we een toename in ‘ephemeral apps’. Heb je een bug? Laat de AI een heel programma schrijven puur om die ene bug te vinden, en gooi het daarna weg. Software wordt kneedbaar en tijdelijk.

AI die op je computer woont, Claude Code en lokale agenten

Jarenlang dachten we dat de toekomst van AI in de cloud lag. Maar 2025 toonde een tegenbeweging met de opkomst van tools zoals Claude Code, een AI-agent die niet in de cloud opereert maar lokaal op je machine.

Het verschil is fundamenteel. Een AI in de cloud is als een consultant die je belt via Zoom. Een AI zoals Claude Code is een collega die naast je zit en toegang heeft tot je bestanden, je lokale omgeving, je configuraties en je data.

Anthropic, de maker van Claude, begrijpt dat snelheid en context cruciaal zijn. Zolang AI niet perfect is, wil je het dichtbij hebben om in te grijpen waar nodig.

De nieuwe interface, van tekst naar visuele interactie

In 2025 was er een verschuiving in de User Interface (UI). Sinds de jaren ’80 weten we dat mensen liever visuele informatie verwerken dan lappen tekst. Toch dwongen de eerste generaties chatbots ons terug naar de command-line interface: typen en lezen.

Modellen zoals Google’s Gemini Nano banana werken niet enkel met tekst. LLM’s beginnen ons te antwoorden in het formaat dat wij verkiezen: afbeeldingen, infographics, slides, en dynamische web-apps. Het gaat hier niet enkel om het genereren van een beeld, maar om een multimediale verweving van tekst, beeld en kennis.

De toekomst van de LLM-interface is geen chatvenster, maar een dynamisch canvas waar de AI informatie visueel en ruimtelijk presenteert.

Pas aan het begin

Volgens Karpathy heeft de industrie nog geen 10% van het potentieel van de huidige modellen benut. Er zijn nog veel ideeën om te testen en concepten om uit te diepen. We zien een snelle vooruitgang, maar er is nog enorm veel werk.