M1, de AI-tornado van MiniMax

M1 van het Chinese MiniMax heeft een contextvenster van 1 miljoen tokens, een hyperefficiënte architectuur en is open-source en legt het vuur aan de schenen van een pak duurdere modellen.

M1, Chinese AI innovatie

MiniMax, een Chinese AI-pionier, wist in het Westen al indruk te maken met hun fotorealistische videomodel ‘Hailuo’. Hun nieuwste model, MiniMax M1 draait rond taal en tekst. Het model is volledig opensource (Apache 2.0 licentie). geen licentiekosten, geen restricties, volledige vrijheid om te testen, implementeren en tweaken.

De release van M1, de aftrap van “MiniMaxWeek”, is een stap om wereldwijd een bredere schare gebruikers en innovatoren aan te spreken.

1 miljoen contexttokens, wat betekent dat

De grootste blikvanger van M1 is haar context window van 1 miljoen tokens. Zo’n context window bepaalt hoeveel tekst, code of data het model tegelijk kan verwerken in één sessie, input en output samen. Traditionele modellen sneuvelen ruim voor die kaap. OpenAI’s GPT-4o kan bijvoorbeeld maar 128.000 tokens aan, wat overeenkomt met het lezen van een lijvige roman.

Google Gemini 2.5 Pro heeft ook 1 miljoen contexttokens, maar MiniMax is voor iedereen open en toegankelijk.

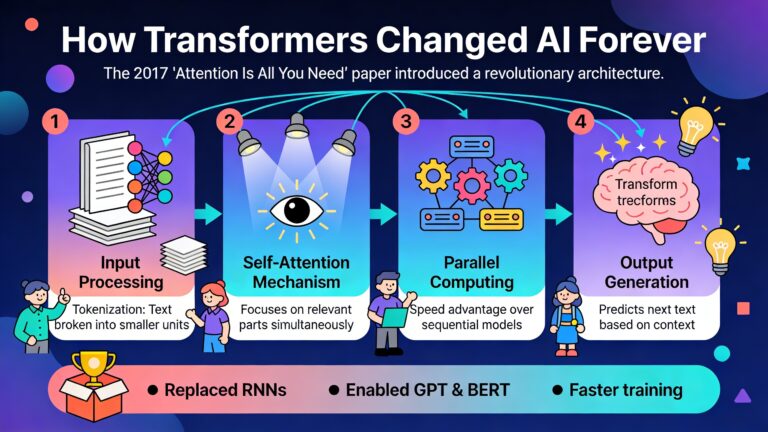

Technische innovatie met mixture of experts en lightning attention

De magie van M1 zit in de architectuur en trainingstechnieken:

- Mixture-of-Experts (MoE): M1 is gebouwd als een hybride MoE-model, waarbij niet alle neurale netwerken tegelijk actief zijn voor elke taak. In plaats daarvan worden slechts de “experts” aangesproken die relevant zijn voor een specifieke input. Dit geeft een enorme boost aan efficiëntie zonder in te boeten op kennis of nuance. Dit is ook de methode die Deepseek gebruikt.

- Lightning attention maakt het mogelijk om lange teksten door te nemen met minder rekenkracht. Door slimme aandacht te geven waar het echt telt, reduceert het model de floating point operations drastisch.

- CISPO-algoritme: MiniMax introduceert een eigen aanpak voor reinforcement learning. Klassieke methodes clippen tokens., CISPO clipt de importance sampling weights. Dit zorgt voor een betere balans tussen snelheid, stabiliteit en prestatie. Voor een generatie van 100.000 tokens verbruikt M1 slechts 25% van de rekenkracht van DeepSeek R1.

Het M1 model bestaat uit 456 miljard parameters. Er worden 45,9 miljard geactiveerd per token. Een krachtpatser die slim en spaarzaam omgaat met haar middelen.

Efficiëntere training

Een van de meest opmerkelijke aspecten van M1 is hoe betaalbaar de training was. OpenAI trainde GPT-4 voor ruim 100 miljoen dollar, DeepSeek-R1 koste maximum 6 miljoen dollar. MiniMax ontwikkelde M1 voor 534.700 dollar gebruik makend van goedkope GPU’s, energieëfficiënte processen en hun vernuftige CISPO-RL-algoritme.

Twee varianten MiniMax-M1-40K en 80K

MiniMax M1 kent twee officiële varianten met een ander denkbudget, hoeveel tokens het model maximaal mag produceren:

- M1-40K

- M1-80K

Waar scoort M1 sterk?

- Wiskunde: Op de AIME 2024 benchmark scoorde de M1-80K variant 86,0% accuraatheid. Andere opensource modellen blijven steken onder 80%.

- Coding & software engineering: Ook in complexe programmeertaken en toont M1 zich stelselmatig sterker dan concurrenten als DeepSeek-R1 en Qwen3-235B-A22B.

- Long context verwerking: Terwijl veel AI’s de draad kwijt raken over duizenden regels tekst, blijft M1 consistent, accuraat en vlot presteren.

Hoewel absolute marktleiders als GPT-4o en Gemini 2.5 Pro het op sommige benchmarks nog iets beter doen, wordt het verschil kleiner.

Developer first

MiniMax stelt voor om vLLM te gebruiken om M1 op te draaien. een serveroplossing geoptimaliseerd voor ‘zware jongens’ uit de modelwereld, met veel aandacht voor geheugenverbruik en efficiënte batching. Alternatieven zoals de Transformers library blijven eveneens ondersteund.

M1 bevat een chatbot API inclusief online search, video- en beeldgeneratie, spraaksynthese en voice cloning. Dit is onderdeel van de structured function calling, ideaal voor geautomatiseerde pipelines en agentic toepassingen.

M1 versus de concurrentie

| Model | Context window | Open source | Parameter count | Rekenkost |

|---|---|---|---|---|

| M1 | 1.000.000 | Ja | 456 miljard | 25% van DeepSeek R1 |

| GPT-4o | 128.000 | Neen | Onbekend | Veel hoger |

| DeepSeek R1 | 125.000 | Ja | 685 miljard | Baseline |

| Gemini 2.5 Pro | 1.000.000 (2.000.000 gepland) | Neen | Onbekend | Hoog |

M1 zet in op verschillende fronten. Het combineert een grote context window met open source toegankelijkheid en een hoge efficiëntie.

Wat brengt de nabije toekomst voor MiniMax en M1?

De release van M1 is nog maar het begin. Tijdens MiniMaxWeek verwacht men bijkomende tools, modellen en updates. MiniMax profileert zich als een uitdager voor de gevestigde waarden in de AI-sector.