Neurosymbolic AI blaast een frisse wind in AI-land

Wanneer je de AI evolutie volgt, lijkt het soms alsof alles draait rond neural networks en massaal geschaalde large language models. Maar er is een opvallende tegenbeweging, neurosymbolic AI.

Deze stroming belooft niet alleen robuustere AI, maar pakt ook fundamentele knelpunten aan zoals dataschaarste, uitlegbaarheid van resultaten en de absurde kost van steeds grotere modellen. Maar wat is neurosymbolic AI nu precies? Is het de oplossing voor het scaling probleem? Wie zet er vandaag al op in? En vormt het de echte opstap richting artificial general intelligence (AGI)? Een diepgaande analyse.

Neurosymbolic AI combineert het beste van twee werelden

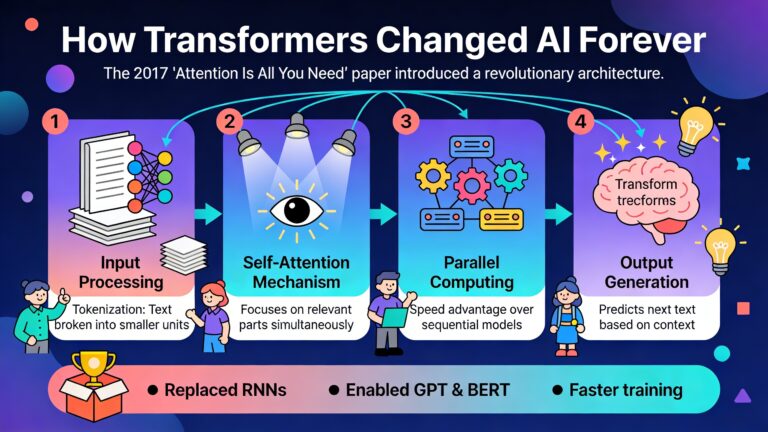

Om het concept te snappen, duiken we eerst terug in de geschiedenis van kunstmatige intelligentie. Twee stromingen domineerden lang:

- Neural networks (connectionism): Dit zijn algoritmes geïnspireerd op het biologische brein, die patronen leren herkennen uit enorme datasets. Ze excelleren bijvoorbeeld in beeldherkenning (denk aan gezichtsherkenning op sociale media) en taalmodellen.

- Symbolische AI (GOFAI, good old fashioned AI): Gebaseerd op expliciete kennisregels en logica (als dit, dan dat). Symbolische systemen zijn sterk in redeneren, interpreteren, verklaren en toepassen van formele logica (expert systems, oude schaakprogramma’s).

Traditioneel waren deze benaderingen elkaars concurrenten, maar neurosymbolic AI smelt ze samen tot één krachtig raamwerk. In zo’n hybride systeem worden lerend vermogen en patroonherkenning (neural) gekoppeld aan inzicht in regels, uitleggend vermogen en structureel redeneren (symbolisch). Concrete voorbeelden? Denk aan een zelfrijdende auto die niet enkel verkeersborden detecteert via deep learning, maar ook meteen de actuele verkeersregels toepast op basis van een symbolisch redeneersysteem en uitlegt waarom ze bepaalde beslissingen neemt.

Dat klinkt evident, maar jarenlang werden hybridetechnieken in de academische AI-wereld ridicuul gevonden. “Zo gek als electriciteit op benzinemotor te kleven in plaats van volledig elektrisch te gaan” dixit Geoffrey Hinton. Pas de laatste jaren vindt die integratie plaats met veelbelovende resultaten.

Het schoentje wringt bij het scaling probleem

Bestaande deep learning-systemen blinken uit in patroonherkenning, zolang ze gevoed worden met massaal veel data en rekenkracht. Maar de scaling is alles aanpak botst limieten:

- Exploderende kosten en ecologische schade: Het trainen van topmodellen (zoals Gemini of GPT-4) vraagt astronomische hoeveelheden energie, met een duizelingwekkend prijskaartje en een niet te onderschatten CO2-uitstoot als gevolg.

- Black box-probleem: Grote neurale netwerken zijn zelden transparant. Waarom kiest het model voor een bepaalde beslissing? Zelf de ontwikkelaars weten het vaak niet. Dat belemmert toepassingen in sectoren waar uitleg, auditbaarheid en veiligheid cruciaal zijn (zoals geneeskunde of rechtspraak).

- Datahonger en generalisatie: Neural netwerken zijn pas echt goed als de situatie voldoende lijkt op wat ze al gezien hebben tijdens hun training. Confronteer je ze met echte out-of-the-box situaties dan missen ze het inzicht of de flexibiliteit om “outside the box” te denken.

- Robustheid en generalisatie: Kleine veranderingen in input leiden soms tot totaal andere output: rare misclassificaties of hallucinaties.

Die combinatie maakt dat het “meer data, meer parameters, meer rekenkracht” verhaal op zijn limieten botst. Het resultaat? Enkel grote techbedrijven kunnen meedraaien in de bovenklasse van AI, terwijl kleinere spelers, universiteiten en onafhankelijke onderzoekers afhaken door torenhoge barrières qua vermogen, data en (eco)budget.

Wat maakt neurosymbolic AI anders?

Neurosymbolic AI biedt een alternatief en een aanvulling:

- Neurale netwerken doen waar ze goed in zijn. Ongestructureerde data verwerken, features extraheren, patronen leren herkennen uit ruwe input (beelden, tekst, geluid).

- Symbolische componenten bouwen daar bovenop expliciete kennislagen (regels, knowledgegraphs, logica, constraints) waarmee het systeem kan redeneren, verklaren en zelfs met beperkte data generaliseren naar nieuwe situaties.

- Door voortdurende terugkoppeling tussen de verschillende lagen ontstaat een slimme feedback-loop. Symboolgedreven kennis stuurt het leren waar nodig bij, terwijl het neuraal deel nieuwe patronen naar boven haalt die eventueel symbolisch kunnen ingeplugd worden.

Uit onderzoek blijkt dat zo’n hybride architectuur niet enkel uitlegbaarheid biedt, maar vooral betere prestaties levert met minder data en parameters.

Door domeinspecifieke kennis compact en expliciet te integreren, moeten modellen niet van nul beginnen bij elke nieuwe taak. Ze beginnen al met een sterke achtergrond. Klassieke deep learning heeft deze achtergrond niet.

Neurosymbolische AI in de praktijk

Hoewel neurosymbolic AI pas sinds kort momentum krijgt in grote AI-labs, zijn er al bekende praktijkvoorbeelden:

- AlphaGo, AlphaFold, AlphaGeometry: DeepMind’s paradepaardjes combineren neural netwerken met symbolisch redeneren. Zo worden in AlphaGo spelposities niet enkel “gezien” maar ook formeel geanalyseerd om de beste zet te berekenen. AlphaFold brengt milieusubsymbolische (neuraal geleerde patronen) samen met symbolische (fysische) wetten voor eiwitvouwing. AlphaGeometry lost complexe wiskundeproblemen op via een combinatie van taalmodellen en deductie-engines.

- OpenAI’s code interpreteren: Moderne grote taalmodellen (o3, GPT-4, Grok 4) doen steeds vaker beroep op externe symbolische tools (zoals code-interpreters of knowledgegraph) om complexe bewerkingen uit te voeren of hun eigen antwoorden te controleren.

- Amazon knowledge graphs: E-commercegigant Amazon bouwt automatisch commonsense knowledge graphs uit klantdata. Zo kunnen aanbevelingssystemen niet enkel correlaties vinden, maar ook uitleggen waarom bepaalde producten samen horen en die heuristiek meenemen naar volledig nieuwe situaties.

- Medische diagnose: Gecombineerde systemen gebruiken deep learning voor het scannen van medische beelden en symbolisch redeneren om diagnoses te onderbouwen aan de hand van medische protocollen en regels.

- Autonome voertuigen: Zelfrijdende auto’s gebruiken deep learning voor reële waarnemingen, maar leggen hun redeneringsproces vervolgens af tegen formele verkeersregels (symbolisch) voor veiligheid en uitlegbaarheid.

- Regulatory compliance en juridisch werk: In sectoren als finance of legal is transparantie essentieel. Neurosymbolic AI controleert documenten, voorspelt compliance risico’s, en biedt “explainable AI” die zowel big data als juridische regels begrijpt.

Neurosymbolic AI, het einde van bigger is always better?

Het dominante paradigma van de afgelopen tien jaar kan je samenvatten als bigger, faster, more. Meer data, meer parameters, snellere hardware. Maar het rendement van de extra schaal krimpt.

Neurosymbolic AI wordt steeds vaker gezien als een antithese tegen de scaling laws. Daar waar klassieke deep learning enorm veel uit data en rekenkracht moet halen om lastige regio’s (“sharpness”) in het algoritmisch landschap op te lossen, gebruiken neurosymbolische systemen symbolen en regels om net door die moeilijkheden heen te surfen. Ze verschuiven complexe delen van het leerproces naar een symbolische ruimte, lossen het met menselijk inzicht op, en nemen de regels op in het model.

Het resultaat:

- Minder trainingdata nodig

- Kleinere, zuinigere modellen (iets wat bijzonder relevant wordt bij edge devices

- Veel sterkere generaliseerbaarheid, ook met “few shot learning”

- Betere uitleg bij AI-beslissingen, essentieel voor vertrouwen in medische, juridische en kritieke domeinen.

Niet alles hangt af van massale investeringen in rekenkracht. Kennis, creativiteit en symbolisch redeneren worden opnieuw fundamentele bouwstenen.

Opent neurosymbolic AI de poort naar artificiële algemene intelligentie

Op de vraag of neurosymbolic AI het pad naar artificiële algemene intelligentie (AGI) effent, zijn de meningen verdeeld. De argumenten zijn boeiend:

- Voorstanders (o.a. IBM Research, DeepMind, Gary Marcus) zien in neurosymbolic AI de enige realistische route naar AGI. Waarom? Omdat menselijke intelligentie ook een hybride vorm van intelligentie is: we combineren routineuze “snelle” associaties (systeem 1, zoals neural networks) met traag, logisch redeneren (systeem 2, zoals symbolic AI).

- Puur opschalen van neurale netwerken lijkt niet de barrière van causale redenering, transfer learning en out-of-distribution generalization te doorbreken. “Alleen meer data en rekenkracht brengt geen causale kennis of gezond verstand voort,” zegt Gary Marcus. Benchmarks bevestigen dat LLM’s falen op basisredeneringen die niet in hun trainingsdata zitten.

- Toch betekent een hybride aanpak niet automatisch dat AGI er al is. Er zijn nog stevige uitdagingen. Het koppelen van symbol grounding (kan het model symbolen linken aan de werkelijkheid?), de automatische ontdekking van nieuwe symbolen, dynamisch redeneren… Veel van die bouwstenen moeten nog uitgevonden, verfijnd of slim geïntegreerd worden.

Voordelen & uitdagingen

Voordelen

- Generaliseert beter met minder data (few-shot learning & transfer learning)

- Verlaagd energieverbruik

- Verlaagd de rekenkracht die nodig is

- Maakt beslissingen transparanter

- Laat domeinexpertise en bestaande kennis toe, snel aanpasbaar aan nieuwe sectoren

- Sterker in causale en samengestelde redeneringen

Uitdagingen

- Efficiënte architectuur: Er zijn veel manieren om neural en symbolic AI te combineren. De ideale architectuur voor algemene intelligentie is (nog) niet gevonden.

- Symbol-grounding-probleem: Hoe link je abstracte symbolen aan sensorische waarnemingen

- Standardisatie, benchmarks en transparantie. Sommige modellen zijn black box. Bedrijven geven niet graag hun implementatiegeheimen prijs.

- Het vinden van een goed evenwicht tussen uitlegbaarheid en optimale prestaties blijft delicaat.

- Opleiding & tooling: Ontwikkelaars en onderzoekers moeten nieuwe vaardigheden en tools ontdekken en creëren.