De grote belofte en de harde realiteit van reasoning AI

Het nieuws bestookt ons met berichten over AI die kan denken. Geavanceerde taalmodellen krijgen reasoning modellen. We krijgen steeds te horen dat deze modellen slimmer worden en straks misschien wel op het niveau van de mens problemen oplossen. Maar als we voorbij de buzz en benchmarks kijken, stellen we ons de vraag, kunnen deze reasoning modellen echt denken? En waarom lopen ze vast zodra problemen echt complex worden?

Waar laten AI reasoning modellen het afweten, waarom zijn ze minder flexibel dan menselijke denkers en welke obstakels moeten nog overwonnen worden om echte intelligentie te benaderen. We bespreken we hoe je reasoning structureel kunt versterken, welke nieuwe modelleringstechnieken hoop bieden en hoe de zoektocht naar Artificial General Intelligence (AGI) de grenzen van het huidige denken verlegt.

Kunnen AI-reasoning modellen echt denken?

Reasoning modellen, zoals de nieuwste Large Language Models (LLMs) in ‘thinking mode’ of Large Reasoning Models (LRMs) worden voorgesteld als denkende machines. Ze breken problemen op in stappen, genereren redeneringen en geven uiteindelijk een antwoord dat vaak verbazend goed lijkt. Maar denken ze echt, of simuleren ze vooral de illusie van denken?

Patroonherkenning vs. Abstract redeneren

Uit onderzoek blijkt dat de meeste reasoning AI’s vooral sterke patroonherkenners zijn. Ze presteren sterk als de testdata sterk lijkt op wat ze tijdens hun training hebben gezien. Diep en abstract begrip ontbreekt. Lewis en Mitchell (2025) demonstreerden hoe GPT-achtige modellen goed presteren op standaard analogie problemen. Ze scoren slecht als er kleine variaties worden gevraagd. Waar mensen flexibel blijven, zijn AI’s star:

- Bij kleine herformuleringen zakken de prestaties sterk.

- AI’s volgen vaak patronen zonder diepgaande begripscontrole.

- Ze slagen onvoldoende in het generaliseren naar compleet nieuwe contexten.

Anders dan de mens laten reasoning LLMs zich ontmoedigen door variaties. Ze kiezen dikwijls voor het eerste (of meest voorkomende) antwoord in plaats van logisch verder te redeneren over mogelijke alternatieven.

De drie regimes: Waar reasoning-modellen het laten afweten

Een recente studie van Apple (The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity) geeft inzicht in waar het fout loopt. Er zijn 3 situaties waar redeneermodellen problemen ondervinden:

- Lage complexiteit: Bij eenvoudige problemen (bv. standaard analogieën of simpele puzzels) scoren standaard LLMs vaak dan redeneermodellen.

- Middelmatige complexiteit: Hier komt de sterkte van reasoningmodellen naar voren. De extra denkinspanning levert betere resultaten op dan de rechtlijnige LLM benadering.

- Hoge complexiteit: Bij uitdagende vraagstukken, zoals problemen met meerdere logische lagen, een onbekende context of veel abstractie loopt alles fout. Hier verdwijnt het voordeel van reasoning compleet en falen ook de geavanceerde LLM’s.

Naarmate een probleem moeilijker wordt, leveren reasoning modellen precies minder denkinspanning (reasoning effort). In plaats van harder te zoeken, geven ze sneller op of genereren ze kortere redeneringen. Dit is niet hoe een mens te werk zou gaan. Mensen doen vaak net meer moeite of proberen alternatieven uit als het moeilijk wordt.

Waarom loopt reasoning AI vast bij complexe problemen?

Het falen van reasoning-modellen bij hoge complexiteit is meer dan gewoon een kwestie van schaalgrootte. Er zijn structurele oorzaken:

Te weinig abstract begrip en generalisatievermogen

Veel van de huidige AI’s generaliseren niet echt. Ze interpoleren tussen gekende voorbeelden uit hun training. Zelfs de meest geavanceerde LLM doet dit. Zodra ze geconfronteerd worden met totaal nieuwe vraagstukken, missen ze het vermogen om abstracte principes te herkennen en toe te passen.

Afhankelijk van patroonherkenning en trainingsdata

In plaats van te denken zoals een mens, voorspellen modellen het volgende woord of symbool dat het meest waarschijnlijk past bij de context, puur uit ervaring met data. Dat werkt verrassend goed tot je context van trainingdata stapt (out-of-distribution).

Louter stappen rekenen volstaat niet

Complexe problemen vragen soms een radicaal nieuwe aanpak. De typische keten van deelopdrachten (Chain of Thought reasoning) faalt als de onderliggende regels of logica onbekend zijn omdat het model geen nieuwe strategieën kan verzinnen.

Beperkt adaptatievermogen

Zelfs de topmodellen stoten op limieten zodra ze zich moeten aanpassen aan volledig nieuwe taken. Waar mensen flexibel van aanpak wisselen, blijven modellen vastzitten in templates die hen ooit succes opleverden.

De Two-System Approach: Wat leren we van psychologie?

De cognitieve psychologie van David Kahneman (Thinking Fast and Slow) onderscheidt twee manieren van denken:

- System 1: Snel, automatisch en intuïtief. Dit is efficiënt voor gekende patronen en dagelijkse beslissingen.

- System 2: Traag, bewust en logisch. Dit is nodig om onbekende of complexe problemen op te lossen.

Huidige AI-modellen zijn briljante “System 1” machines. Ze herkennen bliksemsnel patronen, associëren en reageren. Maar System 2 redeneren, met diepgaande analyse, juiste generalisatie en aanpassing aan onverwachte situaties blijkt moeilijk te modelleren met de huidige generatieve AI-technologieën.

Voor echte AGI (Artificial General Intelligence) is net dit nodig. Een AI moet logisch redeneren, onbekende situaties aanpakken en zelf strategieën bedenken. Dit is meer dan patroonherkenning.

De Abstraction and Reasoning Corpus (ARC) als stresstest voor reasoning AI

Het Abstraction and Reasoning Corpus (ARC) is een testcase voor reasoning AI. Je krijgt enkele input- en outputvoorbeelden, en moet voor nieuwe gevallen de achterliggende regels afleiden zonder voorkennis. Creatieve abstractie op topniveau.

- Wat is nodig? Minimalistisch trainen, een probleem logisch ontleden en de opgepikte regels toepassen op nieuwe data.

- Zonder miljoenen voorbeelden, geen brute force, weinig hints. Pure reasoning, zoals een mens dat zou doen.

De resultaten zijn pover. Bestaande modellen blinken uit in herkenbare taken maar zijn snel het noorden kwijt als de logica onbekend is of varieert. Net wat nodig is voor AI reasoning.

Waar vallen bestaande modellen door de mand?

- Program Synthesis: Gebonden aan hun onderwerp (Domain Specific Language – DSL). Als een taak buiten de gestelde grenzen valt, kunnen ze hun onderwerp niet uitbreiden.

- LLMs (zoals ChatGPT, Gemini): Algemene patroonherkenning. Als de taak sterk afwijkt of complex wordt, kan de LLM enkel interpoleren. Chain of Thought helpt soms om stapjes te expliciteren, maar faalt bij nieuwe problemen.

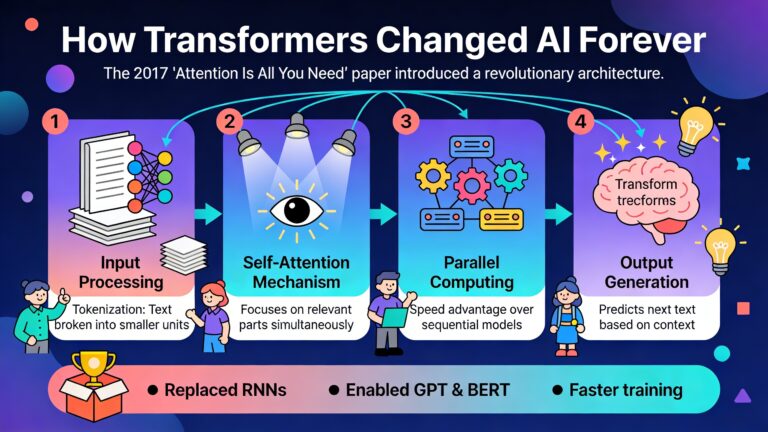

- Transformers: Sterk in patroonherkenning, matig in abstract redeneren. Ze struikelen als de logica anders is dan de bekende patronen.

Zonder generalisatie en adaptatie stoten deze modellen snel op hun plafond.

Waarom helpen meer stappen niet?

Sommige onderzoekers hoopten dat reasoningmodellen geleerd konden worden om meer expliciete denkstappen te nemen. Bijvoorbeeld door nieuwe algoritmes aan te leren tijdens het proces of meer Chain of Thought prompt engineering te gebruiken. Helaas, zo werkt het niet:

- Zelfs als redeneermodellen een correct oplossingsalgoritme aangereikt krijgen, vallen ze terug op hun waarschijnlijkheidsvoorspelling, niet op het bewust volgen van de voorgestelde logische stappen.

- Aks de taak moeilijker wordt, nemen ze eerder minder denkstappen. Niet meer.

- Ze redeneren inconsistent bij het oplossen van gelijkaardige puzzels. Ze onthouden of hergebruiken hun eigen oplossingsstrategieën onvoldoende.

Het probleem lijkt niet oplosbaar met grotere modellen, meer tokens (schaal) of slimmere prompting. Het vereist dieper begrip van abstract denken en aanpassingsvermogen.

Kunnen redeneermodellen denken zoals mensen?

Vergelijkingen tussen mensen en LLMs op analogietaken (UvA, 2025) leggen fundamentele verschillen bloot:

- Mensen scoren consistent bij variaties op een probleem. Reasoningmodellen haken af bij kleine wijzigingen.

- Mensen herkennen structuur en achterliggende principes, niet enkel de zichtbare patronen.

- Bij complexe taken is de mens zijn creativiteit en probleemoplossend vermogen sterker. De kracht van AI blijft beperkt tot het herhalen van gelijkaardige oplossingen.

Reasoning AI is voorlopig een hulpmiddel, geen volwaardige denker of probleemoplosser.

Hoe kunnen we deze limieten doorbreken?

Onderzoekers signaleren vier piste:

1. Leren vanuit menselijke intenties

AI’s die niet enkel menselijke acties imiteren, maar ook de intenties en logische deductie kunnen distileren uit hun gedrag, komen dichter bij het denken van System 2. Door data te verzamelen van hoe mensen taken aanpakken, kunnen modellen abstracte strategieën leren herkennen.

Technieken om intenties te leren

- Topic modeling & sequentiële patronenanalyse: Herkennen van vaak voorkomende acties en het koppelen aan doelen.

- Hidden Markov modellen: Om verbanden te achterhalen tussen opvolgende acties en onderliggende, verborgen intenties.

2. Combinatie van symbolische en neurale modellen

Pure neurale networken blijven steken in patroonherkenning. Door symbolische modellen en neurale netwerken te combineren (hybride modellen), kan je abstracte logica (regels, concepten, redeneringsketens) integreren in de kracht van datagedreven leren.

- Neuro-Symbolic Programming: het neurale netwerk herkent patronen, het symbolisch gedeelte genereert interpreteerbare regels voor abstract denken.

- Differentiable Inductive Logic Programming: Combineert logica met data, zodat modellen beter generaliseren voor nog onbekende taken.

- Symbolic Regression: Voor het ontdekken van onderliggende wiskundige of logische relaties in data.

Voor reasoning zijn deze hybride modellen cruciaal om zowel van beperkte voorbeelden te kunnen leren als nieuwe regels te formuleren.

3. Meta-learning, leren leren om aan te kunnen passen en redeneren

Mensen leren in verschillende contexten door algemene principes op te pikken ongeacht het probleem dat ze proberen op te lossen. Meta-learning AI’s focussen niet op het oefenen van één vaardigheid, maar leren hoe nieuwe taken aan te pakken.

- Recurrent Neural Processes: AI leert sequenties herkennen en zich aan te passen aan nieuwe patronen.

- Prototypical Networks: deze modellen kunnen met enkele voorbeelden nieuwe taken herkennen, structurele overeenkomsten vinden en deze toepassen op nieuwe problemen.

- Meta-Reinforcement Learning (meta-RL): zet in op aanpassingsvermogen door te leren hoe te leren.

Door meta-learning pikken systemen sneller nieuwe taken op. Ze verfijnen hun redeneervermogen naarmate ze geconfronteerd worden met meer variatie.

4. Geavanceerde reinforcement learning voor multi-stap logica en verbeteren van strategieën

Voor echte redenering bij complexe problemen moet een systeem kunnen plannen, multi-stap strategieën ontwikkelen én zich aanpassen als de omgeving verandert. Reinforcement Learning (RL) speelt hierin een hoofdrol.

- Hierarchisch reinforcement learning (HRL): Werk wordt verdeelt in subdoelen. De toplaag plant de strategie, de onderlagen voeren ze uit. Zo kan AI complexe problemen opsplitsen breken en aanpakken zoals mensen het doen.

- Model-Based reinforcement learning: Door modellen van de omgeving te bouwen en mogelijke acties te simuleren, kan AI vooruitdenken en plannen zoals mensen dat ook doen.

- Relational reinforcement learning (RRL): Focust op relaties tussen objecten en handelingen, cruciaal voor abstract reasoning over ruimtes, objecten of causale netwerken.

Reinforcement learning technieken zijn dus essentieel om bruggen te slaan tussen patroonherkenning en echt multi-step reasoning met concrete feedback.

De mens als benchmark voor AI-reasoning

Harder trainen op steeds meer data brengt ons niet dichter bij echte denkkracht.

Reasoning modellen fascineren en zijn tegelijkertijd een bron van frustratie voor gebruikers. Voor het ene probleem verbazen de resultaten, voor andere problemen hallucineren ze er op los en zijn ze totaal onbetrouwbaar. Elke doorbraak begint waar een model faalt. Door het menselijk denken als leidraad te nemen en te investeren in hybride modellen die kunnen abstraheren, zich kunnen aanpassen en logisch kunnen plannen, zetten we stappen richting AGI. Tot dan blijven reasoning modellen een boeiend hulpmiddel voor herkenbare problemen. Menselijke controle blijft noodzakelijk.