Wanneer theorie en praktijk botsen

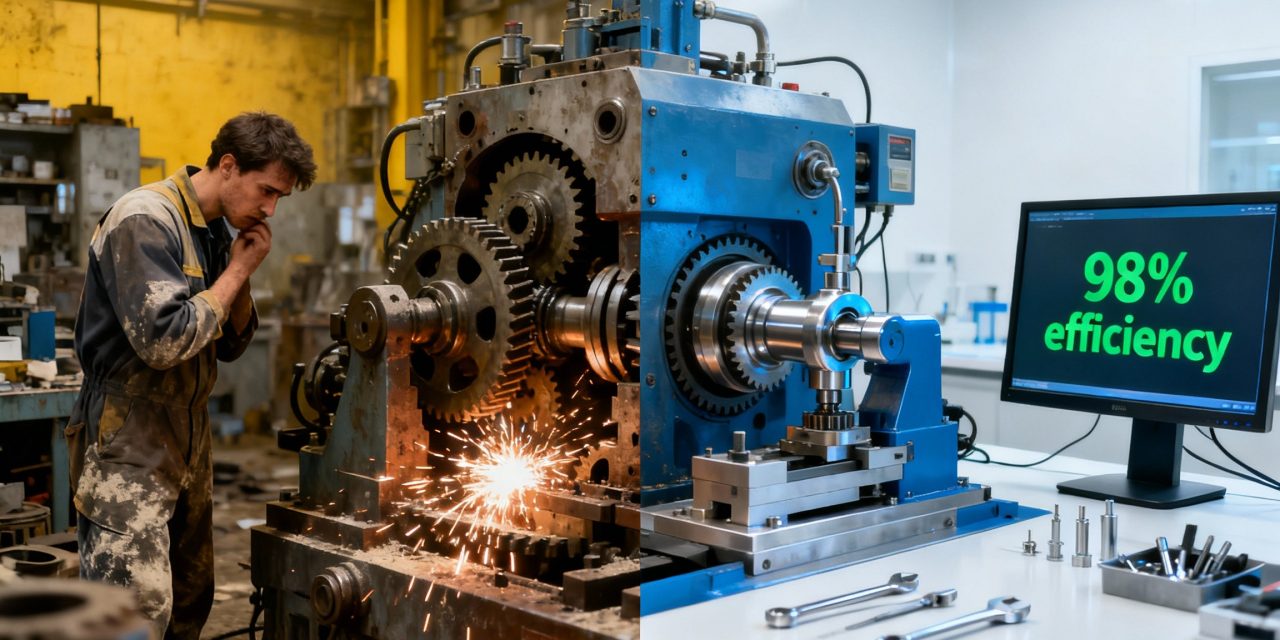

Kunstmatige intelligentie haalt spectaculaire scores op benchmarks en onderzoekstesten. Modellen zoals GPT-5, Claude en Gemini lijken steeds slimmer te worden, met indrukwekkende resultaten op logische puzzels, wiskundige problemen en programmeertaken. Maar hoe vertaalt deze theoretische intelligentie zich naar echte economische waarde? Kunnen AI-systemen daadwerkelijk het werk overnemen van menselijke professionals?

Om deze vraag te beantwoorden, ontwikkelden onderzoekers van Scale AI en het Center for AI Safety een nieuwe maatstaf: de Remote Labor Index. Dit benchmark test niet hoe goed AI presteert op geïsoleerde taken, maar of het volledige, betaalde freelance projecten kan voltooien van begin tot eind. De resultaten zijn verrassend en ontnuchterend tegelijk.

Wat is de remote labor index?

De Remote Labor Index is de eerste benchmark die AI-agents evalueert op hun vermogen om echte, betaalde freelance opdrachten uit te voeren. In plaats van kunstmatige testsituaties, gebruiken de onderzoekers authentieke projecten uit diverse sectoren zoals softwareontwikkeling, grafisch ontwerp, architectuur, video-editing, game development en data-analyse.

Elk project in de index vertegenwoordigt een complete, economisch waardevolle taak die een menselijke professional gemiddeld 11,5 uur kost om te voltooien, met een mediane waarde van 200 dollar. De opdrachten komen met een duidelijke briefing, een prijskaartje en concrete deliverables. Het gaat dus niet om of AI kan helpen bij delen van een project, maar of het als zelfstandige freelancer het volledige werk kan afleveren.

In totaal omvat de Remote Labor Index 240 projecten verspreid over 23 verschillende domeinen. Deze projecten vertegenwoordigen meer dan 6.000 uur aan menselijk werk met een totale waarde van ruim 143.000 dollar. Sommige opdrachten zijn relatief eenvoudig, andere zijn complex en kosten meer dan 10.000 dollar met een uitvoeringstijd van over de 100 uur.

De harde cijfers achter AI-automatisering

De resultaten van het onderzoek zijn verhelderend. De best presterende AI-agent, de Chinese Manus, slaagde erin om slechts 2,5 procent van de freelance projecten succesvol te voltooien. In geld uitgedrukt: waar menselijke freelancers samen 143.991 dollar verdienden aan deze projecten, wist de beste AI-agent slechts 1.720 dollar binnen te halen.

Andere geteste systemen presteerden nog zwakker. Grok van xAI, Claude van Anthropic, ChatGPT van OpenAI en Gemini van Google bleven allemaal onder de 2,5 procent automatiseringsgraad. Dit betekent dat zelfs de meest geavanceerde AI-systemen momenteel 97,5 procent van professioneel freelance werk niet kunnen uitvoeren op een niveau dat een klant zou accepteren.

Deze bevindingen staan in schril contrast met eerdere voorspellingen. In maart 2024 suggereerde Dario Amodei, CEO van Anthropic, nog dat 90 procent van het programmeerwerk binnen enkele maanden geautomatiseerd zou zijn. De Remote Labor Index toont aan dat deze verwachtingen voorbarig waren.

Waarom falen AI-agents zo vaak?

De onderzoekers analyseerden honderden mislukte inzendingen om te begrijpen waar het precies misgaat. Ze ontdekten dat de fouten niet willekeurig zijn, maar in duidelijke patronen voorkomen.

Bij 45,6 procent van de mislukte projecten waren er kwaliteitsproblemen. Het werk was simpelweg niet op het professionele niveau dat een klant zou accepteren. Nog eens 35,7 procent van de inzendingen was onvolledig of verkeerd geformatteerd, met afgekapte video’s, ontbrekende bronbestanden of lege mappen.

Technische problemen en bestandsintegriteit vormden 17,6 procent van de fouten. Daarnaast vertoonde 14,8 procent inconsistenties, waarbij agents er niet in slaagden om visuele of logische samenhang te behouden tussen verschillende bestanden binnen hetzelfde project.

Een concreet voorbeeld illustreert deze problemen. Bij een sieradenontwerp project kreeg een AI-agent de opdracht om een bestaande ringafbeelding aan te passen door de slijpvorm van de diamant te veranderen. In plaats daarvan negeerde het systeem het aangeleverde bestand volledig en genereerde twee compleet nieuwe, AI-gegenereerde afbeeldingen. Deze inzending vertoonde meerdere problemen tegelijk: de kwaliteit was amateuristisch, de briefing werd genegeerd en de twee nieuwe ringen leken niet eens op elkaar.

Waar AI wel succesvol is

Niet alle projecten mislukten. De opdrachten die wel succesvol werden afgerond, vertoonden een duidelijk patroon. Het ging voornamelijk om creatieve projecten waarbij iets vanaf nul moest worden gegenereerd, zoals het maken van geluidseffecten, logo’s of rapporten op basis van een eenvoudige prompt.

Dit onthult een cruciaal inzicht: AI-agents excelleren in het creëren van nieuwe content vanuit een simpele instructie, maar falen bij complexe bewerkingen of het volgen van precieze, meerstapsplannen. Hun generatieve vaardigheden zijn hoog, maar hun vermogen om te functioneren als een betrouwbare, detailgerichte professional is laag.

Dan Hendrycks, directeur van het Center for AI Safety, legt uit dat AI-modellen weliswaar beter zijn geworden in programmeren, wiskunde en logisch redeneren, maar nog steeds worstelen met het gebruik van verschillende tools en het uitvoeren van complexe taken met talrijke stappen. Ze beschikken niet over langetermijngeheugen en kunnen niet continu leren van ervaringen zoals mensen dat doen.

Een tegenwicht tegen overdreven verwachtingen

De Remote Labor Index biedt een belangrijk tegenwicht tegen andere benchmarks die een rooskleuriger beeld schetsen. In september presenteerde OpenAI bijvoorbeeld GDPval, een benchmark die beweert economisch waardevol werk te meten. Volgens GDPval naderen frontier AI-modellen zoals GPT-5 menselijke capaciteiten op 220 taken verspreid over verschillende kantoorbanen.

Het verschil tussen beide benchmarks ligt in de aanpak. Waar GDPval kijkt naar geïsoleerde taken, test de Remote Labor Index complete projecten van begin tot eind. Dit verschil is cruciaal, want het onthult de kloof tussen vaardigheid in afzonderlijke taken en de end-to-end betrouwbaarheid die nodig is om een echt project te voltooien.

Bing Liu, onderzoeksdirecteur bij Scale AI, benadrukt dat we al jaren debatteren over AI en banen, maar dat het meeste hiervan hypothetisch of theoretisch was. De Remote Labor Index brengt eindelijk concrete data in het debat.

Wat betekent dit voor de toekomst van werk?

De bevindingen suggereren dat de angst voor massale, onmiddellijke automatisering niet wordt ondersteund door de data. Het faalpercentage van 97,5 procent toont aan dat AI nog niet in staat is om autonoom complex, professioneel werk uit te voeren.

Toch is het succesverhaal van 2,5 procent ook veelzeggend. Het laat zien dat AI al op professioneel niveau presteert voor bepaalde generatieve taken. Het probleem ontstaat wanneer de job complexe bewerkingen, het gebruik van meerdere tools en het volgen van precieze specificaties vereist.

Dit suggereert dat de onmiddellijke impact niet massale automatisering is, maar eerder augmentatie. AI zal waarschijnlijk eerst fungeren als hulpmiddel dat de productiviteit van professionals vergroot, in plaats van hen volledig te vervangen.

De onderzoekers erkennen dat hun benchmark geen perfecte maatstaf is voor de economische impact van AI. Veel beroepen omvatten taken die niet door de meting worden gedekt, en in de praktijk zullen veel freelancers AI gebruiken als tool om hun productiviteit te vergroten.

Een meetinstrument voor de toekomst

De Remote Labor Index biedt meer dan alleen een momentopname van de huidige situatie. Het creëert een gemeenschappelijke basis om de vooruitgang van AI-automatisering te volgen. Door dezelfde projecten in de toekomst opnieuw te testen, kunnen onderzoekers precies meten hoe snel AI-systemen verbeteren in het uitvoeren van economisch waardevol werk.

Deze data-gedreven aanpak helpt om publieke discussies over AI en automatisering te verankeren in feiten in plaats van speculatie. Het stelt beleidsmakers, bedrijven en werknemers in staat om proactief te navigeren door de veranderingen die AI met zich meebrengt, in plaats van te reageren op overdreven voorspellingen of ongegronde angsten.

De volgende grote uitdaging voor AI-ontwikkelaars is duidelijk: het bouwen van systemen die kunnen evolueren van eenvoudige prompts naar complexe projectuitvoering. De Remote Labor Index biedt het economisch gefundeerde instrument om deze volgende fase te begeleiden en te meten, en zorgt ervoor dat vooruitgang wordt gemeten aan de hand van echte prestaties in plaats van theoretische mogelijkheden.