Van tokens naar concepten

Wie de jongste AI-doorbraken volgt, heeft ongetwijfeld al gehoord van Chain of Thought (CoT) prompting. Hierbij laten we LLM’s (‘Large Language Models’, zoals GPT-4, Llama of Claude) stap voor stap redeneren, zodat ze niet alleen het antwoord uitspuwen maar ook uitleggen hoe ze tot dat antwoord komen. Tot voor kort gebeurde dat altijd met één fundamentele techniek: tekst genereren, token per token, alsof het model woord voor woord zijn gedachtegang uitspreekt.

Maar menselijk denken werkt niet zo strikt lineair of taalgebonden. Mensen spelen razendsnel met associaties, gaan simultaan verschillende gedachtenrichtingen uit, en werken niet alleen met concrete woorden maar vooral met abstracte ideeën of “concepten”. Kunnen we die rijkdom van menselijke denkkracht ook aan LLM’s bezorgen?

Wat is soft thinking precies?

Soft thinking is een volledig nieuwe manier om LLM’s te laten redeneren. In plaats van stapsgewijs tekst (tokens) te genereren zoals in klassieke Chain of Thought promting, werkt het model in een continue ‘concept space’. Hier vormen ‘concept tokens’ de kern: deze zijn niet langer slechts concrete woordjes uit het vocabularium, maar een mix van mogelijke woorden. Deze worden in het model geïnjecteerd als rijke, abstracte pakketten van ideeën.

Kort door de bocht: gewone LLM’s kiezen in elke denkstap één woord (token) als volgende stap in hun redenering. Soft thinking behoudt op elk moment het volledige spectrum van mogelijks relevante woorden—en dus concepten en voert daarmee de denklijn door. Het is zoals iemand die in zijn hoofd nog even over verschillende mogelijkheden blijft nadenken in plaats van halsoverkop voor één richting te kiezen.

- Bij klassieke CoT: het model denkt in een enkele rechte keten. Elk moment kiest het een enkel woord, en verliest meteen de alternatieven uit het oog.

- Bij soft thinking: het model houdt omslachtig, probabilistisch bij welke andere woorden/concepten ook relevant zijn, waardoor het “parallel” meerdere denksporen tegelijk kan evalueren.

Waarom klassieke Chain of Thought een bottleneck is?

Het token-per-token denken van klassieke LLM’s is beperkt omdat:

- Het model moet te vroeg knopen doorhakken, waardoor het een fatale denkfout niet meer kan rechtzetten.

- Abstracte, overkoepelende concepten zijn moeilijk vatten: elk abstract idee moet vertaald worden naar een concreet woord uit het vocabularium.

- Bij complexe problemen is de kans reëel dat het juiste denkpad snel buiten beeld verdwijnt, omdat er telkens maar één mogelijkheid wordt gekozen.

Het is alsof je een puzzel probeert op te lossen en in elke stap direct één stuk moet vastklikken, zonder terug te kunnen of te twijfelen. Mensen denken minder lineair. Ze wikken, wegen, combineren indrukken, en formuleren hun conclusie vaak pas op het eind.

Hoe werkt soft thinking praktisch?

Technisch draait soft thinking rond het idee van een ‘concept token’—een vector die niet één specifieke tokencode (een woord) aanduidt, maar een gewogen mengeling van meerdere tokens. Deze mengeling ontstaat door het volledige voorspelde kansverdeling van het model niet onmiddellijk plat te slaan (zoals bij sampling), maar te gebruiken als “conceptuele superpositie”.

- Het LLM maakt op basis van de context een voorspelling voor de volgende stap: niet de top-token, maar de volledige kansverdeling over alle tokens wordt bewaard.

- Deze ‘concept token’ – een soort vectorieel ideeënpakket – wordt vervolgens omgezet naar een gewogen som van alle token-embeddings (vectoren die alle semantiek in zich dragen).

- Het model zet in de volgende ‘denkstap’ deze abstracte gegeneraliseerde embedding terug als input, waardoor het in de context van veel mogelijkheden blijft denken.

- Pas bij de einduitkomst wordt zoals gewoonlijk weer een concreet antwoord gegenereerd.

De term ‘soft’ verwijst dus naar het behouden van alle mogelijke “zachte” overgangen tussen concepten zonder meteen keihard te moeten kiezen (‘hard selection’). LLM’s hebben op deze manier toegang tot een reuzegroot, continu conceptueel landschap, veel dichter bij hoe mensen zelf ideeën combineren vóór ze tot een verwoording komen.

Waarom maakt soft thinking een verschil?

Het voordeel van soft thinking is tweeledig: efficiënter én krachtiger redeneren.

- Bredere conceptuele dekking: het model verkent in parallell een waaier aan mogelijke manieren om de taak te volbrengen, waardoor moeilijke of onduidelijke problemen minder snel op een dood spoor belanden.

- Meer abstractie & interpretatie: concepten zonder kant-en-klare taaluitdrukking kunnen veel beter verweven worden in de tussenstappen van het redeneren. Denk aan logische schakelingen, intense associaties of subtiele betekenislagen die nauwelijks in gewone woorden te vatten zijn.

- Efficiënter: doordat het model sneller convergeert naar een oplossing, zijn er minder tokens en minder rekenwerk nodig per antwoord. Dit werd aangetoond in experimenten met wiskunde en coderen. Tot 22% minder tokens gebruikt voor het juiste antwoord, en een hoger accuraatheid. De pass@1 accuraatheid steeg tot 2,5% in bepaalde benchmarks.

- Betere foutcorrectie: het model blijft langer alternatieven openhouden, waardoor het meer ruimte krijgt om zichzelf te corrigeren.

Een paar concrete cijfers uit recente studies

In evaluaties over diverse LLM-architecturen (bijvoorbeeld Llama en Qwen in grootte-klasse van 32B tot 70B parameters) op benchmarks als GSM8K (rekensommen) en HumanEval (codeeropdrachten), zagen onderzoekers:

- Accuraatheid: stijging van 1 tot 2,5 procentpunt in ‘Pass@1’.

- Token-efficiëntie: tot meer dan 20% minder tokens nodig.

- Leesbaarheid: soft thinking zorgt niet voor ‘gebrabbel’, maar blijft net zeer interpreteerbaar, heldere redeneringsketens in mensentaal.

Zo wordt duidelijk dat soft thinking geen mathematische truc is die het model domweg sneller doet gokken, maar echt het denkkader verbreedt: de LLM zoekt en vindt gerichtere, abstractere logica, en dat in recordtempo.

Soft thinking en de link met menselijke cognitie

Wie vertrouwd is met cognitiewetenschap, merkt een opmerkelijke parallel: waar klassieke AI-modellen stevig leunen op het starten vanuit tokens en syntaxis (denk aan het ‘language of thought’-concept), verschuift soft thinking naar een flexibeler, contextgevoeliger netwerk van concepten. Meer zoals mensen denken met een associatief veld.

De idee dat menselijke gedachten vooral uit conceptuele structuren bestaan, en niet uit lineaire woordenreeksen, is al decennia bekend in de filosofie en psychologie. Denk aan de ideeënleer van Plato. Denk aan het verschil tussen het in beelden, sferen en verbanden denken tegenover puur rationeel woorden opvolgen. Soft thinking fungeert dus als een digitale vertaling van denken in betekeniswolken of conceptuele netwerken.

Zijn er beperkingen aan soft thinking?

Natuurlijk zijn er ook enkele praktische uitdagingen:

- LLM’s zijn getraind om discrete tokens (tekstreeksen) te verwerken, dus genereren van en werken met ‘concept tokens’ vraagt een aanpassing bij inference.

- Soft thinking werkt het best bij complexe redeneertrajecten. Indien de taak strak omlijnd of puur feitelijk is, is het verschil minimaal.

- Omdat het model zo’n rijke kansverdeling behoudt, moeten aanpassingen op systeemniveau en extra metrics zoals entropie-monitoring (‘cold stop’) worden ingezet om eindeloze herhaling (collapse) te vermijden.

Deze kinderziektes worden al vlot aangepakt via slimmere monitoring en afkapmechanismen.

Soft thinking is meer dan een tweak

Soft thinking markeert een verschuiving van ‘hard’ digitaal denken naar een meer analoge, vloeiende vorm van redeneren in LLM’s. Het brengt de performantie van taalmodellen niet alleen dichter bij menselijke denkkracht, maar maakt ze ook krachtiger, token-efficiënter en conceptueel flexibeler. Bijzonder interessant voor complexe of open teksttaken.

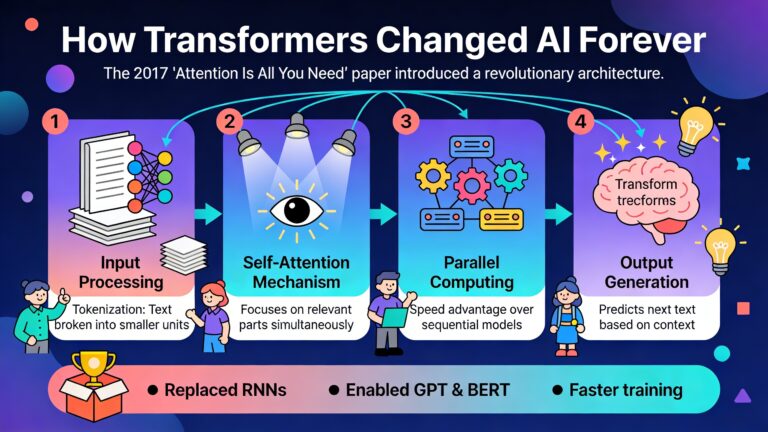

Voor de AI-wereld is dit een van de eerste voorbeelden waar machine reasoning de strikte grenzen van taal achter zich laat. Soft thinking opent zo de deur naar een nieuwe generatie modellen die niet langer enkel woorden aaneenrijgen, maar echt denken in concepten. En te oordelen naar de recente onderzoeksresultaten, is deze zachte denkomslag misschien wel de grootste doorbraak voor reasoning-AI sinds de komst van transformers.

Het is nu wachten op modellen die niet enkel getraind zijn in traditionele, token-gebaseerde taalproductie, maar die tijdens hun opleiding ook vertrouwd geraken met het verwerken van deze probabilistische conceptrijke input. Soft thinking biedt daarvoor het framework. Wie weet versmelten we binnenkort taal, logica en menselijk denken in één vloeiende, digitale redenerende machine. Wittgenstein zei, “De grenzen van mijn taal, betekenen de grenzen van mijn wereld”. Met soft thinking verleggen we die grenzen.