De toekomst van AI hangt sterk samen met de beschikbaarheid van energie. Een studie van november 2025 onderzoekt hoe lokale AI inzetten bijdraagt tot een betere gebruik van energie en hardware. Intelligence per Watt: Measuring Intelligence Efficiency of Local AI vat de belangrijkste bevindingen samen over de haalbaarheid en efficiëntie van het lokaal uitvoeren van Large Language Model (LLM) queries, als alternatief voor de traditionele, gecentraliseerde cloudinfrastructuur. De studie is gebaseerd op empirisch onderzoek, met meer dan 1 miljoen queries, meer dan 20 modellen en 8 hardware-accelerators,

De exponentiële groei in de vraag naar AI-inferentie legt een toenemende druk op cloud-datacenters. Twee parallelle ontwikkelingen, de opkomst van krachtige, compacte lokale LLM’s (≤ 20B actieve parameters) en de toegenomen capaciteit van consumenten-hardware (lokale accelerators), creëren een kans om een aanzienlijk deel van deze werklast te herverdelen naar lokale apparaten zoals laptops en smartphones.

Om de effectiviteit van deze verschuiving te meten, wordt de metric Intelligentie per Watt (IPW) gebruikt. IPW is taaknauwkeurigheid gedeeld door het gemiddelde stroomverbruik. Het biedt een uniforme maatstaf voor zowel de capaciteit van een model als de efficiëntie van de hardware.

De Opkomst van Lokale AI-Inferentie

Overbelasting van de Cloud

De vraag naar LLM-inferentie groeit exponentieel, van miljarden naar biljoenen queries per dag. Deze groei legt een immense druk op de gecentraliseerde cloudinfrastructuur. De projectie is dat de wereldwijde datacenter-capaciteit tegen 2030 bijna zal verdrievoudigen, waarbij AI-workloads circa 70% van de nieuwe vraag voor hun rekening nemen. Het voldoen aan deze vraag vereist kapitaalinvesteringen van meer dan 5 biljoen dollar. Deze schaalbaarheidsproblemen haan niet alleen over rekenkracht, maar ook de productie van chips, de capaciteit van elektriciteitsnetten en de beschikbaarheid van andere resources.

Meer lokale inferentie

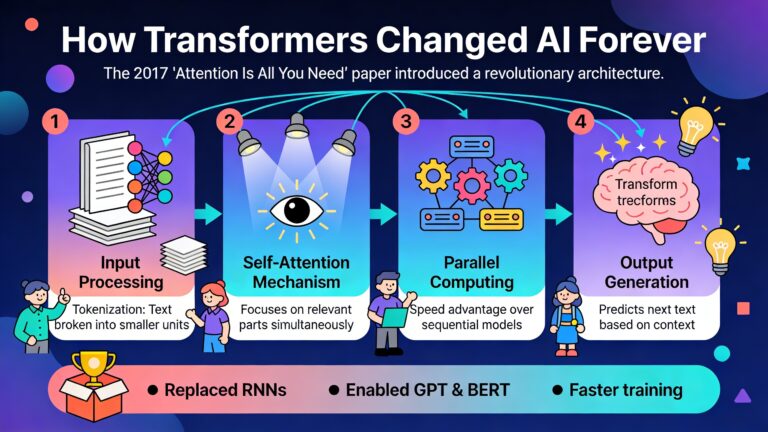

Een historische parallel kan worden getrokken met de evolutie van mainframes naar personal computers. Die werd gedreven door een verdubbeling van de prestatie-per-watt elke 1,5 jaar tussen 1946 en 2009. Dit doet zich nu ook voor LLM-inferentie, aangedreven door twee convergerende trends:

- Betere lokale LLM’s: recente ontwikkelingen hebben geleid tot kleine, efficiënte modellen (minder dan 20 miljard actieve parameters), zoals QWEN3 en GPT-OSS, die op veel taken concurrerende prestaties leveren van veel grotere ‘frontier’ modellen.

- Snellere lokale accelerators: de Apple M4 Max en AMD Ryzen AI beschikken nu al over voldoende geheugencapaciteit en rekenkracht om deze lokale modellen te draaien. De geheugencapaciteit van lokale accelerators is sinds 2012 met een factor 126 toegenomen.

Deze trends roepen de vraag op of lokale inferentie een levensvatbare strategie is om de vraag op de gecentraliseerde infrastructuur te herverdelen.

Intelligentie per Watt’ (IPW)

Om de haalbaarheid van lokale inferentie systematisch te beoordelen, is een meeteenheid nodig die zowel de geleverde intelligentie (modelcapaciteit) als de benodigde energie (hardware-efficiëntie) omvat.

- Definitie: Intelligentie per Watt (IPW) wordt gedefinieerd als de taaknauwkeurigheid gedeeld door het gemiddelde stroomverbruik in watt.

IPW = acc(m, q) / P(m, h, q)

- Doel: IPW meet de fundamentele afweging bij lokale inferentie. Het behalen van voldoende taakprestaties binnen de beperkte stroombudgetten van consumentenapparaten.

- Complementaire Metrieken: Naast IPW worden ook op energie gebaseerde metrieken gebruikt, zoals Nauwkeurigheid per Joule (APJ), die de totale efficiëntie per query vastlegt, inclusief de latency.

Deze metrieken maken een objectieve vergelijking mogelijk tussen verschillende model-accelerator-configuraties en kwantificeren de efficiëntiewinsten die voortkomen uit innovaties in zowel modellen als hardware.

Conclusies

Een grootschalige studie onderzocht 20+ lokale LLM’s op 8 hardware-accelerators (zowel lokaal als in de cloud) aan de hand van een dataset van meer dan 1 miljoen real-world single-turn chat- en redeneerqueries.

Conclusie 1: Dekking van queries door lokale LLM’s

Lokale modellen zijn in staat een substantieel en groeiend deel van de huidige LLM-workloads af te handelen.

- Dekking: Door queries intelligent te routeren naar het meest geschikte lokale model, kan 88,7% van alle onderzochte queries correct worden beantwoord. Dit toont de kracht van modeldiversiteit, aangezien het beste individuele model (GPT-OSS-120B) “slechts” 71,3% dekt.

- Groei: De capaciteit van het beste individuele lokale model is tussen 2023 en 2025 met een factor 3,1 toegenomen, van 23,2% dekking naar 71,3%.

- Verschillen per domein: Lokale modellen presteren uitstekend op creatieve en conversatietaken (>90% dekking), maar hebben meer moeite met zeer gespecialiseerde technische domeinen zoals engineering en life & physical science. Chat-queries worden significant beter afgehandeld dan complexe redeneerqueries.

| Jaar | Beste lokale model | Succespercentage |

| 2023 | Mixtral-8x7B-v0.1 | 23,2% |

| 2024 | Llama-3.1-8B-Instruct | 48,7% |

| 2025 | GPT-OSS-120B | 71,3% |

Conclusie 2: de intelligentie efficiëntie is de laatste 2 jaar meer dan 5 keer verbeterd

De efficiëntie van lokale inferentie is de afgelopen twee jaar dramatisch verbeterd door de gecombineerde vooruitgang in modellen en hardware.

- Totale IPW-verbetering: De metriek ‘Intelligentie per Watt’ is tussen 2023 en 2025 met een factor 5,3 verbeterd.

- Bijdrage van modellen en hardware: Deze verbetering kan worden opgesplitst in:

- Een factor 3,1x door betere modellen (algoritmische vooruitgang).

- Een factor 1,7x door betere accelerators (hardware-vooruitgang).

- Nauwkeurigheid per Joule: een vergelijkbare analyse van nauwkeurigheid per Joule toont een verbetering van 18 keer over een periode van 16 maanden (april 2024 – augustus 2025), opgesplitst in een factor 5,9x door hardware en 3,1x door modellen.

Deze compounding-effecten tonen een snelle en voorspelbare toename in de levensvatbaarheid van lokale inferentie.

Conclusie 3: sterke resourcebesparingen door gebruik van hybride systemen

Door lokale en cloudinfrastructuur samen te gebruiken, kunnen aanzienlijke besparingen worden gerealiseerd. Een simulatie met 80,2 miljoen queries over 24 uur toont de volgende resultaten:

| Routeringsstrategie | Energiebesparing | Computebesparing | Kostenbesparing |

| Oracle router (perfecte routering) | 80,4% | 77,3% | 73,8% |

| 80% accurate router (realistisch) | 64,3% | 61,8% | 59,0% |

| 60% accurate router | 48,4% | 46,7% | 44,5% |

Zelfs met een onvolmaakte, maar realistische routeringsnauwkeurigheid van 80%, wordt het merendeel van de theoretisch maximale winst behaald. Belangrijk is dat deze besparingen worden gerealiseerd zonder vermindering van de antwoordkwaliteit, omdat queries die niet lokaal kunnen worden opgelost, automatisch worden doorgestuurd naar een krachtiger cloudmodel.

Aanvullende Inzichten

Efficiëntiekloof tussen lokale en cloud accelerators

Hoewel lokale accelerators steeds capabeler worden, behouden cloud-grade accelerators een aanzienlijk efficiëntievoordeel wanneer dezelfde workloads worden uitgevoerd.

- Intelligentie per Watt: De NVIDIA B200 (cloud) is 1,40x efficiënter dan de Apple M4 Max (lokaal). De SambaNova SN40L (cloud) is 1,78x efficiënter.

- Intelligentie per Joule: De efficiëntiekloof wordt nog groter wanneer ook de latency wordt meegerekend. De NVIDIA B200 is tot 2,3x efficiënter en de SambaNova SN40L zelfs tot 7,4x efficiënter dan de Apple M4 Max.

Deze kloof komt voort uit gespecialiseerde hardware optimalisaties in enterprisegrade accelerators. Dit toont aan dat er aanzienlijke ruimte is voor verbetering in toekomstige ontwerpen van lokale accelerators die specifiek zijn gericht op AI-workloads.

Impact van quantisation

Modelquantisation, het verminderen van de numerieke precisie van bijvoorbeeld FP16 naar FP8 of FP4, is een effectieve techniek om lokale inferentie verder te optimaliseren.

- Energiebesparing: quantisation van FP16 naar FP4 levert een energiebesparing op van 3x tot 3,5x.

- Nauwkeurigheidsverlies: Deze besparing gaat gepaard met een voorspelbaar en relatief klein verlies in nauwkeurigheid van ongeveer 2,5 procentpunt per precisiestap.

Dit maakt van quantisation een praktische afweging voor systeemontwerpers om de efficiëntie te maximaliseren op basis van de specifieke eisen van een applicatie.

Prestaties van open source versus closed modellen

De analyse vergelijkt ook de prestaties van open-source modellen met toonaangevende closed-source modellen (zoals GPT-5 en Gemini 2.5 Pro).

- Frontier modellen: Het beste opensource model (QWEN3-235B) nadert de prestaties van de beste closed-source modellen, met een prestatiekloof van slechts 3,4-5,1% op redeneerbenchmarks.

- Lokale modellen (minder dan 20 miljard parameter): Voor modellen die praktisch lokaal inzetbaar zijn, is de prestatiekloof groter, variërend van 11% tot 16%.

Conclusie

De verschuiving van volledig gecentraliseerde naar hybride lokaal-cloud AI-inferentie is niet langer een theoretische mogelijkheid, maar een praktische realiteit. Lokale LLM’s kunnen reeds een groot deel (88,7%) van de single-turn chat- en redeneerqueries succesvol afhandelen. De efficiëntie, gemeten in Intelligentie per Watt, verbetert snel door de vooruitgang in modelarchitecturen en accelerator-hardware.

Door lokale en cloud-resources als complementair te beschouwen en queries intelligent te routeren, kunnen organisaties het energieverbruik, de rekenkracht en de kosten met 60 tot 80% reduceren zonder in te boeten op de kwaliteit van de antwoorden. Terwijl modellen en hardware blijven evolueren, zal IPW een belangrijke metric blijven om de voortgang te volgen en de steeds groter wordende rol van lokale AI te meten.