Een nieuwe speler in de AI-race

De wereld van kunstmatige intelligentie staat nooit stil, en net wanneer je denkt dat de Amerikaanse techgiganten onverslaanbaar zijn, komt er een verrassing uit China. Moonshot AI, een relatief jonge speler uit Beijing, heeft met Kimi K2 Thinking een model gelanceerd dat op verschillende vlakken beter presteert dan OpenAI’s GPT-5 en Anthropic’s Claude Sonnet 4.5. En dat voor een fractie van de kosten.

Wat maakt dit model zo bijzonder? Het gaat niet alleen om de prestaties op papier, maar ook om hoe het model denkt en werkt. Kimi K2 Thinking is gebouwd als een “thinking agent”, een AI die kan plannen, redeneren en zich aanpassen om complexe problemen op te lossen.

Wat is Kimi K2 Thinking precies?

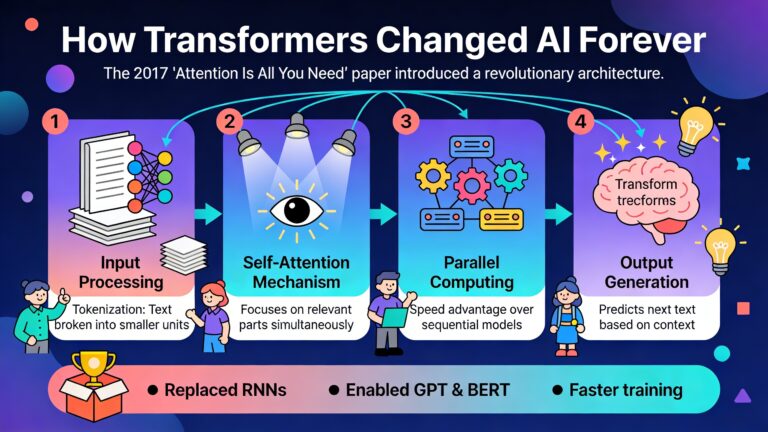

Kimi K2 Thinking is een open-source AI-model dat draait op een Mixture-of-Experts (MoE) architectuur met maar één biljoen parameters in totaal, waarvan 32 miljard actief zijn bij elke taak. Denk aan het model als een team van 384 gespecialiseerde schrijvers, waarbij voor elke vraag de 8 meest relevante experts worden geraadpleegd.

Het model beschikt over een contextvenster van 256.000 tokens, wat neerkomt op ongeveer 200.000 woorden. Je kan volledige boeken of uitgebreide documenten invoeren zonder dat het model de draad kwijtraakt. Een ander technisch hoogstandje is de native INT4 quantization, een techniek die het model compacter maakt en ongeveer twee keer zo snel laat werken zonder veel kwaliteitsverlies.

Wat Kimi K2 Thinking echt onderscheidt, is het vermogen om tussen de 200 en 300 opeenvolgende tool calls uit te voeren zonder menselijke tussenkomst. Het model kan zelfstandig zoeken op het web, code uitvoeren, zijn eigen antwoorden verifiëren en zijn aanpak aanpassen op basis van wat het vindt. Het resultaat is agentic AI, kunstmatige intelligentie die autonoom kan handelen.

Waar blinkt Kimi K2 Thinking in uit?

Redeneren met tools

Het model is sterk wanneer het gebruik kan maken van externe tools. Op benchmarks zoals Humanity’s Last Exam (HLE) scoort Kimi K2 Thinking 44,9 punten met tools, tegenover 41,7 voor GPT-5. Bij wiskundige problemen zoals AIME 2025 haalt het bijna perfecte scores (99+), en op IMO-AnswerBench presteert het zelfs beter dan GPT-5 met 78,6 versus 76 punten.

Dit betekent dat het model uitstekend is in het stapsgewijs oplossen van complexe wiskundige, fysische en logische problemen. Het kan zijn redenering uitbreiden, tools gebruiken zoals Python of webzoekopdrachten, en zijn aanpak aanpassen naarmate het meer informatie verzamelt.

Agentic search en informatie verzamelen

Hier toont Kimi K2 Thinking zijn ware kracht. Op BrowseComp, een benchmark die test hoe goed AI-modellen het web kunnen doorzoeken, scoort het 60,2 punten, ruim voor GPT-5’s 54,9 en ver boven Claude’s 24,1. Op Frames, een andere zoekbenchmark, haalt het 87,0 punten tegenover GPT-5’s 86,0.

Het model kan complexe zoekopdrachten uitvoeren in meerdere stappen, informatie uit verschillende bronnen combineren en zijn zoekstrategie aanpassen op basis van wat het vindt. Dit maakt het ideaal voor onderzoekstaken waarbij je door bergen informatie moet spitten om het juiste antwoord te vinden.

Creatief schrijven met diepgang

Een verrassende sterkte van Kimi K2 Thinking is creatief schrijven. Het model gebruikt dramatisch meer thinking tokens dan andere modellen. Voor een simpele vraag zoals “schrijf een goede zin over kaas” genereert het maar liefst 1.595 thinking tokens, terwijl DeepSeek er slechts 110 gebruikt.

Wat betekent dit? Het model besteedt enorm veel rekenkracht aan het overwegen van verschillende benaderingen, het herzien van zijn keuzes en het verfijnen van zijn output voordat je een enkel woord ziet. Het kan een zin genereren, deze evalueren, tekortkomingen vinden en herschrijven, allemaal voordat het het eindresultaat toont. Menselijke schrijvers doen dit constant, maar de meeste AI-modellen niet.

Gebruikers melden dat het model literaire intelligentie toont, niet alleen woorden aan elkaar rijgt, maar ook smaak, structurele ambitie, metaforische controle en terughoudendheid onder extreme beperkingen demonstreert. Het kan originele concepten genereren en emotionele intelligentie tonen die aanvoelt als literair werk.

Coderen met veelzijdigheid

Op het gebied van programmeren presteert Kimi K2 Thinking solide, hoewel niet altijd het beste. Op SWE-bench Verified scoort het 71,3 punten, iets lager dan GPT-5’s 74,9 en Claude’s 77,2. Maar bij meertalig programmeren overtreft het GPT-5 met 61,1 versus 55,3 punten.

Het model gedraagt zich als een ingenieur die weet wat op te zoeken in plaats van syntaxis uit het hoofd te kennen. Het kan functionele tools bouwen, bugs opsporen en code genereren in verschillende programmeertalen.

Waar schiet Kimi K2 Thinking tekort?

Redeneren zonder tools

Wanneer het model geen gebruik kan maken van externe tools, verliest het terrein op GPT-5. Bij pure, pen-en-papier logica zonder hulpmiddelen scoort GPT-5 bijvoorbeeld 93,3 op HMMT 2025, terwijl Kimi K2 Thinking 89,4 haalt. Niet slecht, maar ook niet het beste.

Dit suggereert dat het model is geoptimaliseerd voor situaties waarin het kan handelen en tools kan gebruiken, maar minder sterk is in zuivere abstracte redenering zonder externe hulp.

Algemene kennis en feitenkennis

Op benchmarks die algemene kennis testen, zoals MMLU-Pro, scoort GPT-5 87,1 punten tegenover Kimi K2 Thinking’s 84,6. Het verschil is niet enorm, maar consistent. Bij gespecialiseerde domeinen zoals geneeskunde wordt het verschil groter: GPT-5 haalt 67,2 op HealthBench, terwijl Kimi K2 Thinking op 58,0 blijft steken.

Het model is een generalist die kan praten over veel onderwerpen, maar niet altijd de diepte heeft van modellen die specifiek zijn getraind op bepaalde vakgebieden. Het kan uitleggen, maar je merkt dat het zich comfortabeler voelt bij het oplossen van problemen dan bij het geven van gestructureerde feitelijke uitleg.

Verbositeit en snelheid

Een belangrijk nadeel is dat Kimi K2 Thinking breedsprakerig is. Het gebruikt ongeveer 140 miljoen tokens om bepaalde evaluaties te voltooien, dat is 2,5 keer meer dan DeepSeek V3.2 en twee keer meer dan GPT-5.

Wat betekent dit praktisch? Ten eerste hogere kosten: meer tokens betekent meer rekenkracht en dus hogere API-kosten. Ten tweede langere wachttijden: het basismodel genereert ongeveer 8 tokens per seconde, wat voor real-time toepassingen zoals klantenservice of snelle Q&A te traag kan zijn.

Voor creatief schrijven is deze verbositeit een voordeel, want die extra thinking tokens vertalen zich in dieper redeneren en hogere kwaliteit. Maar voor productietoepassingen waar snelheid telt, kan dit een probleem zijn.

De economische kant van het verhaal

Het model kostte slechts 4,6 miljoen dollar om te trainen, een fractie van de miljarden die OpenAI naar verluidt in GPT-4 heeft gestoken. Sam Altman praat over 1,4 biljoen dollar aan infrastructuurinvesteringen over acht jaar, terwijl Moonshot AI met wat zakgeld een concurrerend model heeft gebouwd.

Deze efficiëntie komt voort uit slimme ontwerpkeuzes: de MoE-architectuur betekent dat slechts 32 miljard parameters actief zijn per token, en de INT4 quantization vermindert drastisch het geheugen- en rekengebruik. Sommige experts schatten dat met nieuwere chips zoals Blackwell het model voor minder dan 3 miljoen dollar getraind had kunnen worden.

Voor gebruikers betekent dit betaalbare toegang. Via de Moonshot API kost het model 0,60 dollar per miljoen input tokens en 2,50 dollar per miljoen output tokens. Een boek van 80.000 woorden genereren kost ongeveer 0,30 tot 0,50 dollar, vergeleken met 8.000 tot 16.000 euro voor een boek geschreven door een menselijke ghostwriter.

Wat betekent dit voor de toekomst?

Voor het eerst kan een open-source model uit China op gelijke voet concurreren met de beste gesloten modellen uit Silicon Valley. Dit heeft verschillende implicaties.

Ten eerste verschuift de balans van macht. Chinese AI-labs zoals DeepSeek, Qwen en Moonshot worden huishoudnamen, en hun aandeel in de mondiale AI-mindshare groeit snel. Wat begon als een achterstand van jaren is nu een kwestie van maanden, of volgens Nvidia-CEO Jensen Huang, “nanoseconden”.

Ten tweede komt er druk op de Amerikaanse techgiganten. Ze kunnen niet langer alleen vertrouwen op benchmarkscores om hun waarde te rechtvaardigen. Ze moeten zich onderscheiden door betere gebruikerservaringen, betrouwbaardere diensten en unieke functies die verder gaan dan wat open-source modellen bieden.

Ten derde democratiseert dit AI-ontwikkeling. Wanneer een state-of-the-art model open-source is en lokaal kan draaien (met de juiste hardware), ben je niet meer afhankelijk van één aanbieder. Je kunt het fine-tunen op je eigen schrijfstijl, implementeren via tientallen providers, of zelfs volledig offline gebruiken.

Hoe kun je Kimi K2 Thinking gebruiken?

Het model is al breed beschikbaar. Je kunt het testen via OpenRouter in je browser of rechtstreeks via de Moonshot API. Als je 247GB Ram hebt, kun je het model lokaal draaien met Ollama.

Voor schrijvers is Kimi K2 Thinking een fantastische brainstormpartner. Het kan de saaie delen van schrijven afhandelen, zoals het opstellen van vulscènes of het behouden van continuïteit, terwijl jij je focust op de creatieve hoogtepunten. Het is een onvermoeibare medewerker die eindeloos herziet zonder te klagen.