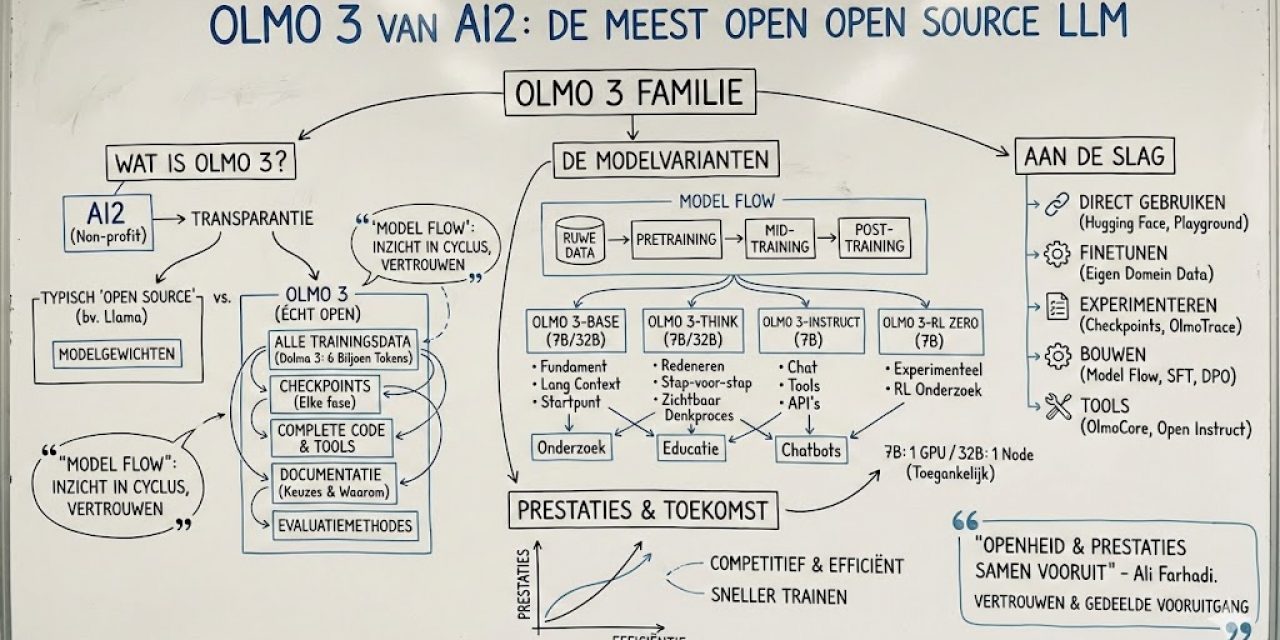

Wat is Olmo 3 eigenlijk?

Olmo 3 is de nieuwste generatie taalmodellen van het Allen Institute for Artificial Intelligence (Ai2), een non-profit onderzoeksinstituut dat zich volledig toelegt op het ontwikkelen van transparante AI-systemen. Waar veel bedrijven claimen dat hun modellen open source zijn, gaat Ai2 een stap verder door niet alleen de modelgewichten vrij te geven, maar letterlijk alles wat nodig is om het model te begrijpen, te reproduceren en aan te passen.

Het bijzondere aan Olmo 3 is dat het een complete modelfamilie vormt met verschillende varianten die elk hun eigen specialisatie hebben. Je krijgt niet zomaar een eindproduct, maar inzicht in de volledige ontwikkelingscyclus – van ruwe trainingsdata tot het uiteindelijke model. Dit noemen de onderzoekers de model flow, en het is precies deze openheid die Olmo 3 onderscheidt van andere zogenaamde open source modellen.

De modellen zijn beschikbaar in twee formaten: 7 miljard parameters en 32 miljard parameters. Die keuze is niet toevallig. Een 7B-model kan je finetunen op een enkele GPU, terwijl een 32B-model nog steeds op één node past zonder dat je dure infrastructuur nodig hebt. Het is groot genoeg om indrukwekkende prestaties te leveren, maar klein genoeg om toegankelijk te blijven voor onderzoekers en ontwikkelaars zonder enterprise-budgetten.

Waarom is Olmo 3 echt open source?

Hier wordt het interessant. Als je kijkt naar populaire open source modellen zoals Meta’s Llama-serie, dan krijg je wel de modelgewichten, maar niet het volledige verhaal. Je weet niet precies welke data gebruikt werd, hoe de trainingsrecepten eruitzagen, of welke keuzes gemaakt werden tijdens het ontwikkelingsproces. Het is een beetje alsof je een recept krijgt voor een gerecht, maar zonder de exacte ingrediënten of bereidingswijze.

Ai2 pakt dit fundamenteel anders aan. Bij Olmo 3 krijg je toegang tot:

- Alle trainingsdata: De volledige Dolma 3-dataset met bijna 6 biljoen tokens, inclusief webdata, GitHub-code, wetenschappelijke papers en wiskundige content

- Checkpoints van elke fase: Niet alleen het eindresultaat, maar ook tussentijdse versies tijdens pretraining, mid-training en post-training

- Complete code en tools: Alle scripts, frameworks en utilities die gebruikt werden om het model te bouwen

- Gedetailleerde documentatie: Technische rapporten die precies uitleggen welke keuzes gemaakt werden en waarom

- Evaluatiemethodes: De volledige testsuites en benchmarks om prestaties te meten

Deze transparantie heeft een praktisch doel. Als je wilt begrijpen waarom een model zich op een bepaalde manier gedraagt, kan je met OlmoTrace letterlijk terugkijken naar de trainingsdata die dat gedrag heeft gevormd. Je kan experimenteren met verschillende fases, je eigen data toevoegen tijdens mid-training, of een eerder checkpoint gebruiken dat beter bij jouw use case past.

Mark Beccue, analist bij Omdia, vat het mooi samen: “Ze blijven maar itereren op wat als ideaal beschouwd wordt. Als je het over openheid hebt, omarmen zij dat echt.” Het gaat niet alleen om toegang tot het model, maar om vertrouwen, verantwoordelijkheid en gedeelde vooruitgang in AI-ontwikkeling.

De verschillende Olmo 3-modellen

Olmo 3 bestaat uit meerdere varianten die elk hun eigen sterke punten hebben. Laten we ze eens doornemen:

Olmo 3-Base (7B en 32B)

Dit is het fundament van de hele familie. Olmo 3-Base is getraind op een brede mix van tekst, code en wiskundige content, en presteert uitstekend in programmeren, leesbegrip en wiskundige probleemoplossing. Het bijzondere is dat het model ook goed werkt met lange contexten – tot 65.000 tokens, wat neerkomt op ongeveer 48.000 woorden. Dat is zestien keer meer dan zijn voorganger.

De Base-modellen zijn ideaal als startpunt voor verder onderzoek. Je kan ze gebruiken voor continued pretraining op specifieke domeinen, of als basis voor je eigen finetuning-experimenten. Volgens Ai2 vereist Olmo 3-Base 7B 2,5 keer minder rekenkracht om te trainen dan Llama 3.1 8B, wat het een stuk toegankelijker maakt.

Olmo 3-Think (7B en 32B)

Dit is het paradepaardje van de familie en Ai2’s eerste reasoning model. Olmo 3-Think is specifiek getraind om stap voor stap door complexe problemen te redeneren, waarbij het zijn denkproces zichtbaar maakt. Je ziet letterlijk hoe het model tot een antwoord komt, wat enorm waardevol is voor onderzoek en educatie.

De 32B-versie is volgens Ai2 het sterkste volledig open reasoning model in zijn klasse. Het presteert vergelijkbaar met modellen als Qwen 3-32B-Thinking, maar is getraind op slechts een zesde van het aantal tokens. Op wiskundige benchmarks zoals MATH en OMEGA scoort het uitstekend, en ook voor code-intensieve taken via HumanEvalPlus levert het sterke resultaten.

Wat Olmo 3-Think bijzonder maakt, is dat je de tussenliggende redeneerstappen kan inspecteren en terugkoppelen naar de trainingsdata. Dit maakt het mogelijk om te begrijpen waarom het model bepaalde conclusies trekt, en om het gedrag aan te passen waar nodig.

Olmo 3-Instruct (7B)

Deze variant is geoptimaliseerd voor efficiënte inferentie en dagelijks gebruik. Olmo 3-Instruct is getraind om instructies op te volgen, meerdere gespreksrondes aan te kunnen, en te werken met externe tools en API’s. Denk aan het ophalen van actuele informatie, het aanroepen van functies, of het verbinden met databases.

In benchmarks presteert Olmo 3-Instruct beter dan vergelijkbare modellen zoals Qwen 2.5, Gemma 3 en Llama 3.1, en komt het dicht in de buurt van de Qwen 3-familie. Het is een solide keuze voor chatbots, data processing en toepassingen waarbij je het model wilt integreren met bestaande systemen.

Olmo 3-RL Zero (7B)

Dit is een experimentele variant die specifiek ontwikkeld is voor reinforcement learning-onderzoek. Olmo 3-RL Zero bouwt voort op de Base-versie en is beschikbaar in vier subvarianten, elk getraind op verschillende soorten data: wiskunde, code, instructievolging en algemene chat.

Deze variant is bedoeld om complexe redeneerbehavior te bootstrappen en duidelijke benchmarking van RL-algoritmes mogelijk te maken. Het is vooral interessant voor onderzoekers die willen experimenteren met nieuwe trainingstechnieken.

Hoe kan je met Olmo 3 aan de slag?

Het mooie van de volledige openheid van Olmo 3 is dat je op elk punt in het ontwikkelingsproces kan inspringen. Hier zijn enkele concrete manieren om ermee te werken:

Direct gebruiken

De eenvoudigste manier is om gewoon te starten met een van de beschikbare modellen. Je kan ze downloaden via Hugging Face of uitproberen in de Ai2 Playground. Alle modellen zijn uitgebracht onder de Apache 2.0-licentie, wat betekent dat je ze vrij kan gebruiken, aanpassen en zelfs commercieel inzetten.

Finetunen voor jouw domein

Stel dat je een model wilt voor medische toepassingen of juridische teksten. Je kan starten met Olmo 3-Base en je eigen domeinspecifieke data toevoegen tijdens de mid-training fase. Ai2 levert alle scripts en tools die je nodig hebt om je eigen datasets te cureren, te tokenizen en te dedupliceren – precies zoals zij dat deden voor Dolma 3.

Pradeep Dasigi, senior onderzoeker bij Ai2, legt uit: “Omdat alle datarecepten open zijn, kunnen ontwikkelaars altijd hun eigen datasets cureren als ze het willen specialiseren naar een specifiek domein. De rapporten die we uitbrengen vertellen duidelijk wat werkte en wat niet. Ze kunnen onze recepten gebruiken om hun eigen datasets te creëren en snel iets te bouwen dat echt voor hen werkt.”

Experimenteren met checkpoints

Misschien past een eerder checkpoint beter bij jouw use case dan het finale model. Omdat Ai2 checkpoints van elke belangrijke trainingsmijlpaal beschikbaar stelt, kan je kiezen welke versie je als startpunt neemt. Je kan ablatiestudies uitvoeren op specifieke fases, of onderzoeken hoe bepaalde capabilities zich ontwikkelen over tijd.

Bouwen met de model flow

De volledige model flow is niet alleen een record van hoe Ai2 Olmo 3 bouwde, maar ook een herbruikbaar framework voor jouw eigen systemen. Je kan je eigen supervised finetuning (SFT) of direct preference optimization (DPO) recept ontwikkelen, of een nieuwe reinforcement learning-doelstelling inpluggen om verschillende trade-offs te onderzoeken.

Hanna Hajishirzi, directeur AI bij Ai2, benadrukt het belang hiervan: “Deze hele modelontwikkeling noemen we ‘model flows’, en ze zijn allemaal zo belangrijk om te delen omdat ze oneindige aanpassing mogelijk maken. Ontwikkelaars kunnen verschillende stukken en verschillende fases van de modelontwikkeling nemen en dan hun eigen model bouwen.”

Gebruik maken van de tools

Ai2 biedt een complete toolkit voor het werken met Olmo 3:

- OlmoCore: Het trainingsframework voor snelle, eenvoudige configuratie

- Data preprocessing tools: Ultra-efficiënte fuzzy deduplicatie en grootschalige data cleaning

- Open Instruct: De post-training pipeline

- Evaluatietools: Utilities voor reproduceerbare evaluaties en het verwijderen van testsets uit trainingsdata

- OlmoTrace: Voor het traceren van modeloutputs terug naar trainingsdata in real-time

Prestaties en efficiëntie

Olmo 3 bewijst dat je niet hoeft te kiezen tussen efficiëntie en prestaties. De modellen presteren net zo goed of beter dan veel grotere concurrenten. Olmo 3-Base 32B overtreft andere volledig open base modellen, en Olmo 3-Think 32B is volgens Ai2 het sterkste volledig open thinking model.

Op benchmarks voor programmeren, leesbegrip en wiskundige probleemoplossing scoort Olmo 3 indrukwekkend. Het handhaaft kwaliteit bij lange contexten en integreert naadloos met reinforcement learning workflows. De training gebeurde op een cluster van maximaal 1.024 H100 GPU’s, waarbij een throughput van 7.700 tokens per device per seconde werd bereikt voor de 7B-versie.

Interessant is ook dat Ai2 de efficiëntie van hun post-training code aanzienlijk verbeterde. Door supervised finetuning te verplaatsen van Open Instruct naar OlmoCore, verhoogden ze de throughput met een factor 8. Voor reinforcement learning training bereikten ze een verbetering van factor 4, wat resulteert in significant goedkopere en snellere trainingsruns.

De toekomst van open source AI

Olmo 3 vertegenwoordigt een fundamenteel andere benadering van AI-ontwikkeling. In plaats van black boxes die je moet vertrouwen op basis van marketingclaims, krijg je volledige transparantie en controle. Je kan het model bestuderen, auditeren en verbeteren. Je kan experimenteren met elke trainingsfase en precies begrijpen hoe verschillende technieken bijdragen aan de capabilities van het model.

Ali Farhadi, CEO van Ai2, vat de visie samen: “Olmo 3 bewijst dat openheid en prestaties samen kunnen vooruitgaan. Door de volledige model flow te delen, geven we onderzoekers, ontwikkelaars en builders alles wat ze nodig hebben voor AI-ontwikkeling op frontier-schaal die efficiënt, reproduceerbaar en gebouwd is om de wetenschap te dienen.”

Voor de AI-gemeenschap betekent dit dat er nu een volledig transparant alternatief bestaat voor closed-source modellen. Of je nu onderzoeker bent die fundamentele vragen wil beantwoorden over hoe taalmodellen leren, ontwikkelaar die een gespecialiseerd model wil bouwen voor jouw toepassing, of gewoon nieuwsgierig bent naar hoe deze systemen werken – Olmo 3 biedt de tools en transparantie om dat mogelijk te maken.

De modellen zijn nu beschikbaar via Hugging Face en de Ai2 Playground. Alle data, code en documentatie is vrij toegankelijk onder permissieve open source licenties. Het is een uitnodiging aan de AI community om te valideren, te bekritiseren en voort te bouwen op deze fundamenten. Want uiteindelijk gaat echte openheid in AI niet alleen over toegang, maar over vertrouwen, verantwoordelijkheid en gedeelde vooruitgang.