Hoe kiezen voor AI-methodes

Hoe kies je de juiste AI-methode voor jouw specifieke toepassing? Net zoals scheikundigen de periodieke tabel van Mendeljev gebruiken om elementen te begrijpen en te voorspellen, hebben onderzoekers nu een vergelijkbaar systeem ontwikkeld voor AI-methodes. Dit raamwerk, het Deep Variational Multivariate Information Bottleneck (DVMIB), biedt een gestructureerde manier om verschillende AI-benaderingen te begrijpen, te vergelijken en toe te passen.

Het onderzoek, uitgevoerd door wetenschappers van Emory University, introduceert een kader dat tientallen bestaande AI-methodes verenigt onder één overkoepelend principe. Het stelt ontwikkelaars in staat om nieuwe, probleemspecifieke algoritmes te ontwerpen met een duidelijk begrip van waarom en hoe ze werken.

Orde scheppen in de chaos

De onderzoekers stonden voor een fundamentele uitdaging in het veld van machine learning. Er bestaan talloze methodes voor dimensionaliteitsreductie en representatieleren, van klassieke benaderingen zoals Principal Component Analysis (PCA) tot geavanceerde deep learning-technieken zoals Variational Autoencoders (VAE) en moderne contrastieve leermethodes. Elk van deze methodes heeft zijn eigen wiskundige afleidingen, assumpties en toepassingsgebieden.

Het probleem? Er was geen systematische manier om deze methodes met elkaar te vergelijken of om te beslissen welke aanpak het beste past bij een specifiek probleem. Onderzoekers en ontwikkelaars moesten vaak trial-and-error gebruiken, wat tijdrovend en inefficiënt is. Het doel van dit onderzoek was daarom tweeledig: ten eerste een uniform raamwerk creëren dat bestaande methodes kan herformuleren, en ten tweede een aanpak bieden voor het ontwerpen van nieuwe, op maat gemaakte AI-methodes.

Waar de machine learning-gemeenschap zich vaak richt op het bereiken van nauwkeurigheid zonder noodzakelijk te begrijpen waarom een systeem werkt, wilden de onderzoekers de fundamentele, verenigende principes ontdekken die verschillende AI-methodes met elkaar verbinden.

De rol van de loss functie in AI-modellen

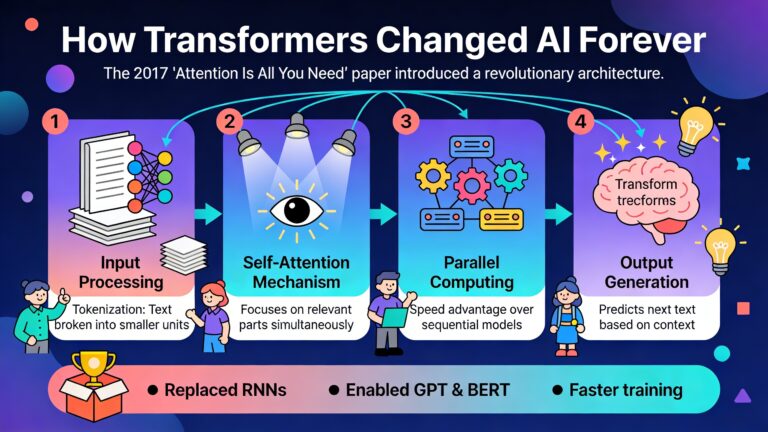

Om te begrijpen waarom dit raamwerk zo belangrijk is, moeten we eerst de centrale rol van de loss functie in AI-modellen begrijpen. Een loss functie is het kompas van een AI-systeem. Het vertelt het algoritme hoe goed of slecht het presteert en in welke richting het moet verbeteren.

Stel je voor dat je een AI-model traint om afbeeldingen te herkennen. De loss functie meet het verschil tussen wat het model voorspelt en wat de werkelijke uitkomst zou moeten zijn. Door deze fout te minimaliseren, leert het model geleidelijk betere voorspellingen te maken. Verschillende loss functies leiden tot fundamenteel verschillende soorten modellen met verschillende eigenschappen.

De trade-off tussen compressie en reconstructie

Het DVMIB-raamwerk is gebaseerd op het principe van de information bottleneck. Aan de ene kant wil je data comprimeren tot een compacte representatie (denk aan het samenvatten van een boek tot de kernpunten). Aan de andere kant wil je genoeg informatie behouden om de originele data te kunnen reconstrueren of om nuttige voorspellingen te maken.

Deze trade-off wordt gecontroleerd door een parameter β (bèta) in de loss functie. Een kleine β-waarde resulteert in sterkere compressie, terwijl een grote β-waarde zorgt voor betere reconstructie. Het is alsof je een knop hebt waarmee je kunt draaien om te bepalen hoeveel informatie je wilt behouden voor het oplossen van een specifiek probleem.

Wat het raamwerk zo krachtig maakt, is dat het laat zien hoe verschillende bekende AI-methodes eigenlijk variaties zijn op dit basisthema.

Hoe het raamwerk ontstond

De ontwikkeling van dit raamwerk was geen rechte lijn. De onderzoekers brachten jaren door met wiskundige afleidingen, waarbij ze letterlijk met de hand berekeningen maakten op whiteboards. Het was een proces van trial and error, waarbij ze telkens opnieuw begonnen na het volgen van doodlopende paden.

De wiskundige fundamenten

Het raamwerk is gebaseerd op het concept van Bayesiaanse netwerken en multivariate information. In essentie definieert het twee graphs: een encoder-graph die modelleert hoe gecomprimeerde variabelen worden verkregen uit observaties, en een decoder-graph die een generatief model specificeert voor de data vanuit de gecomprimeerde variabelen.

De informatie van de encoder-graaf wordt geminimaliseerd (voor sterke compressie), terwijl de informatie van de decoder-graaf wordt gemaximaliseerd (voor nauwkeurige reconstructie). Deze trade-off wordt gecontroleerd door de β-parameter, wat resulteert in de volgende algemene loss functie:

ℒ = β × Iencoder – Idecoder

Wat elegant is aan deze formulering, is dat verschillende keuzes voor de encoder- en decoder-graphs leiden tot verschillende bekende AI-methodes. Het raamwerk biedt dus een periodieke tabel waarin elke methode zijn eigen plaats heeft, gedefinieerd door zijn specifieke graphstructuur.

Hoe gebruik je deze inzichten?

De waarde van dit raamwerk ligt niet alleen in theoretische elegantie, maar vooral in de praktische toepasbaarheid. Hier zijn enkele concrete manieren waarop je deze inzichten kunt gebruiken:

Kiezen van de juiste methode voor jouw probleem

Het raamwerk helpt je begrijpen welke AI-methode het beste past bij de structuur van jouw data.

De onderzoekers toonden aan dat methodes die beter aansluiten bij de structuur van het probleem betere latente ruimtes produceren. Dit werd gemeten aan de hand van classificatienauwkeurigheid, dimensionaliteit van de latente variabelen en sample-efficiëntie.

Ontwerpen van nieuwe, op maat gemaakte algoritmes

Misschien wel de krachtigste toepassing is het vermogen om nieuwe methodes te ontwerpen. Door de encoder- en decoder-graphs aan te passen aan jouw specifieke probleem, kun je een loss functie afleiden die perfect is afgestemd op jouw behoeften.

Voorspellen van data-efficiëntie

Een belangrijk praktisch voordeel is dat het raamwerk helpt inschatten hoeveel trainingsdata je nodig hebt.

Verminderen van computationele kosten

Door de beste AI-aanpak te kiezen, help je voorkomen dat je features encodeert die niet belangrijk zijn. Minder data betekent minder rekenkracht, wat het systeem milieuvriendelijker maakt. Dit opent ook de deur naar experimenten voor problemen die we nu niet kunnen oplossen omdat er niet genoeg bestaande data is.

Toekomstperspectieven en bredere impact

Het DVMIB-raamwerk opent deuren naar tal van toekomstige ontwikkelingen. De onderzoekers zijn bijzonder geïnteresseerd in hoe het kan helpen patronen in biologische systemen te detecteren, wat kan leiden tot inzichten in processen zoals onze cognitieve functie.

Een fascinerende vraag die ze onderzoeken is of we een methode ontwikkelen die ons in staat stelt de overeenkomsten te zien tussen een machine learning-model en het menselijk brein? Dit zou ons kunnen helpen beide systemen beter te begrijpen.

Een kompas voor de AI-toekomst

Het Deep Variational Multivariate Information Bottleneck-raamwerk vertegenwoordigt een belangrijke stap vooruit in ons begrip van AI-methodes. Door een periodieke tabel te bieden voor verschillende benaderingen, geeft het onderzoekers en ontwikkelaars een principiële manier om methodes te kiezen, te vergelijken en te ontwerpen.

Zoals de periodieke tabel van elementen de scheikunde transformeerde door orde te scheppen in schijnbare chaos, zo belooft dit raamwerk hetzelfde te doen voor het veld van kunstmatige intelligentie. Het is een kompas dat ons helpt navigeren door het steeds complexer wordende landschap van AI-methodes.